Robots.txt chặn Googlebot phải làm sao?

**Khi *robots.txt chặn Googlebot*, bạn cần khắc phục ngay lập tức để không ảnh hưởng đến khả năng index website. Để giải quyết tình trạng **robots.txt chặn Googlebot phải làm sao, hãy sửa đổi file robots.txt, đảm bảo Googlebot và các công cụ tìm kiếm khác có thể truy cập các trang quan trọng, đồng thời kiểm tra lại bằng Google Search Console để xác nhận việc khắc phục lỗi. Việc này đặc biệt quan trọng nếu bạn đang trong ngành đăng ký mã vạch sản phẩm và cần sản phẩm của mình hiển thị rõ ràng trên Google.

Robots.txt chặn Googlebot phải làm sao khi trang web không hiển thị trên Google?

Nếu bạn phát hiện robots.txt chặn Googlebot và website của bạn bị ảnh hưởng nghiêm trọng đến khả năng hiển thị, điều đầu tiên cần làm là không hoảng loạn. Tình trạng robots.txt chặn Googlebot có thể sửa chữa được bằng cách chỉnh sửa file này. Một file robots.txt không chuẩn SEO có thể là nguyên nhân chính. Đối với các doanh nghiệp đăng ký mã vạch sản phẩm, việc này càng cấp bách để thông tin sản phẩm được Google lập chỉ mục. Vấn đề robots.txt chặn Googlebot là một trong những lỗi SEO kỹ thuật phổ biến.

Bước 1: Xác định các trang bị robots.txt chặn Googlebot

Để biết robots.txt chặn Googlebot phải làm sao, điều đầu tiên là xác định chính xác những phần nào của trang web đang bị chặn.

- Sử dụng Google Search Console (GSC): Đây là công cụ hữu hiệu nhất để kiểm tra tình trạng robots.txt của tôi.

- Vào mục “Công cụ kiểm tra URL” (URL Inspection tool) và nhập các URL quan trọng của bạn. GSC sẽ cho bạn biết liệu URL đó có bị robots.txt chặn Googlebot hay không.

- Sử dụng “Báo cáo phạm vi lập chỉ mục” (Index Coverage report) để xem các trang bị lỗi “Bị loại trừ bởi robots.txt”.

- Công cụ “Trình kiểm tra tệp robots.txt” (robots.txt Tester) trong GSC cũng giúp bạn kiểm tra các quy tắc cụ thể trong file của mình.

- Kiểm tra thủ công tệp robots.txt:

- Truy cập

yourdomain.com/robots.txtđể xem file. - Tìm các dòng

Disallow:có thể đang vô tình chặn Googlebot truy cập các thư mục hoặc tệp quan trọng. Ví dụ:Disallow: /sẽ chặn toàn bộ website, hoặcDisallow: /wp-admin/chỉ chặn phần quản trị. Cần lưu ý rằng việc robots.txt chặn Googlebot không phải lúc nào cũng là lỗi, đôi khi đó là chủ đích cho các trang không cần lập chỉ mục.

- Truy cập

Bước 2: Chỉnh sửa file robots.txt để không chặn Googlebot

Khi đã xác định được nguyên nhân robots.txt chặn Googlebot, bước tiếp theo là chỉnh sửa nó. Để giải quyết robots.txt chặn Googlebot phải làm sao, hãy đảm bảo bạn chỉ cho phép Googlebot truy cập những gì cần thiết.

- Truy cập file robots.txt:

- Bạn có thể truy cập file này qua FTP/SFTP, trình quản lý tệp của cPanel hoặc qua các plugin SEO như Yoast SEO, Rank Math (nếu bạn dùng WordPress).

- Loại bỏ các lệnh Disallow không cần thiết:

- Nếu bạn thấy

Disallow: /và muốn toàn bộ trang web được lập chỉ mục, hãy xóa dòng này hoặc thay thế bằngAllow: /. - Nếu có các dòng

Disallow: /trang-quan-trong/đang chặn các trang bạn muốn index, hãy xóa chúng. - Ví dụ về cách chỉnh sửa robots.txt để Googlebot không bị chặn:

- Để cho phép tất cả các trình thu thập thông tin:

User-agent: *

Allow: /

- Để cho phép Googlebot truy cập mọi thứ:

User-agent: Googlebot

Allow: /

- Để chỉ chặn một số trang cụ thể (mà bạn không muốn Googlebot lập chỉ mục), ví dụ trang cảm ơn hoặc trang đăng nhập:

User-agent: *

Disallow: /thank-you-page/

Disallow: /login/

- Để cho phép tất cả các trình thu thập thông tin:

- Nếu bạn thấy

- Cẩn thận khi chỉnh sửa: Một lỗi nhỏ cũng có thể làm robots.txt chặn Googlebot toàn bộ website hoặc các phần quan trọng khác.

Bước 3: Kiểm tra robots.txt sau khi chỉnh sửa

Sau khi sửa file để khắc phục tình trạng robots.txt chặn Googlebot, bạn cần kiểm tra lại để đảm bảo mọi thứ hoạt động đúng như mong đợi.

- Sử dụng công cụ kiểm tra robots.txt của Google Search Console:

- Tải lên file robots.txt đã chỉnh sửa và chạy kiểm tra. Công cụ sẽ mô phỏng cách Googlebot đọc file của bạn và chỉ ra bất kỳ lỗi nào hoặc các quy tắc

Disallowngoài ý muốn. Điều này giúp bạn xác nhận rằng robots.txt không còn chặn Googlebot nữa.

- Tải lên file robots.txt đã chỉnh sửa và chạy kiểm tra. Công cụ sẽ mô phỏng cách Googlebot đọc file của bạn và chỉ ra bất kỳ lỗi nào hoặc các quy tắc

- Kiểm tra lại bằng “Công cụ kiểm tra URL”:

- Dán lại các URL đã bị chặn trước đó vào công cụ này. Nếu mọi thứ đúng, bạn sẽ thấy thông báo URL hiện tại có thể được lập chỉ mục (hoặc một thông báo tương tự).

Bước 4: Yêu cầu Google lập chỉ mục lại (nếu cần)

Nếu website của bạn đã bị robots.txt chặn Googlebot trong một thời gian dài, Google có thể mất thời gian để thu thập thông tin lại. Để rút ngắn thời gian, hãy kích hoạt việc thu thập thông tin lại. Đây là một bước quan trọng để đưa web lên Google sau khi khắc phục lỗi robots.txt chặn Googlebot.

- Sử dụng “Yêu cầu lập chỉ mục” (Request Indexing) trong GSC:

- Sau khi kiểm tra URL thành công (tại Bước 3), bạn sẽ có tùy chọn “Yêu cầu lập chỉ mục”. Googlebot sẽ ưu tiên kiểm tra lại các URL này.

- Gửi lại Sitemap (nếu có thay đổi đáng kể):

- Trong Google Search Console, vào mục “Sơ đồ trang web” (Sitemaps) và gửi lại sitemap của bạn. Điều này thông báo cho Google về các trang mới hoặc đã thay đổi, giúp Googlebot thu thập thông tin hiệu quả hơn, đặc biệt quan trọng để giải quyết robots.txt chặn Googlebot trên quy mô lớn.

Robots.txt chặn Googlebot phải làm sao để tránh lỗi tương lai?

Phòng ngừa luôn tốt hơn chữa bệnh, đặc biệt khi liên quan đến việc robots.txt chặn Googlebot. Việc biết robots.txt chặn Googlebot phải làm sao không chỉ là sửa lỗi mà còn là thiết lập các quy trình phòng ngừa.

- Hiểu rõ về file robots.txt: Nắm vững cấu trúc và cú pháp của file robots.txt là chìa khóa. Hiểu các lệnh

User-agent,Disallow,Allow, vàSitemapsẽ giúp bạn tránh những sai lầm ảnh hưởng đến việc robot chặn Google bot hay robot txt chặn Googlebot. - Sử dụng robots.txt một cách cẩn thận:

- Chỉ chặn các trang thực sự không cần thiết được hiển thị trên kết quả tìm kiếm (ví dụ: các trang admin, trang cảm ơn, trang tạm thời, các trang có nội dung trùng lặp).

- Không sử dụng robots.txt để ẩn thông tin nhạy cảm. Nếu bạn muốn bảo vệ một trang, hãy sử dụng mật khẩu hoặc phương pháp xác thực khác, vì Googlebot có thể bỏ qua robots.txt trong một số trường hợp. Robots.txt không phải là công cụ bảo mật.

- Kiểm tra định kỳ file của bạn bằng Trình kiểm tra robots.txt của GSC.

- Thường xuyên kiểm tra Google Search Console: Theo dõi báo cáo “Phạm vi lập chỉ mục” để phát hiện sớm các vấn đề “Bị loại trừ bởi robots.txt” hoặc các lỗi khác. Nếu bạn thường xuyên thêm thông tin sản phẩm và thực hiện đăng ký mã vạch sản phẩm, việc này càng quan trọng để trang web lên Google.

- Tránh dùng robots.txt để chặn nội dung trùng lặp: Để xử lý nội dung trùng lặp, hãy sử dụng thẻ

rel="canonical"thay vì robots.txt chặn Googlebot. - Cân nhắc các thẻ meta robots: Đôi khi, thẻ meta robots (

<meta name="robots" content="noindex, nofollow">) có thể hiệu quả hơn trong việc ngăn Google lập chỉ mục một trang cụ thể, đồng thời vẫn cho phép Googlebot thu thập thông tin trang đó để theo dõi các liên kết. Đây là giải pháp thay thế nếu bạn lo lắng về việc robots.txt chặn Googlebot sai cách.

Nếu lỗi robots.txt chặn Googlebot xảy ra, điều quan trọng nhất là phải hành động nhanh chóng và có hệ thống. Một chiến lược SEO toàn diện bao gồm cả việc theo dõi và tối ưu hóa file robots.txt sẽ giúp website của bạn luôn được các công cụ tìm kiếm yêu thích. Để giúp website của bạn đăng ký mã vạch sản phẩm được Google index nhanh nhất, việc này là tối cần thiết.

Tại sao robots.txt chặn Googlebot lại là vấn đề nghiêm trọng?

Câu hỏi robots.txt chặn Googlebot phải làm sao trở nên cấp bách vì nó ảnh hưởng trực tiếp đến sự hiện diện trực tuyến của bạn.

- Mất khả năng hiển thị: Khi robots.txt chặn Googlebot, các trang web của bạn sẽ không bao giờ xuất hiện trên kết quả tìm kiếm của Google, ngay cả khi nội dung của bạn chất lượng cao. Điều này đặc biệt tai hại cho các doanh nghiệp đăng ký mã vạch sản phẩm muốn sản phẩm của mình được khách hàng tiềm năng tìm thấy.

- Giảm lưu lượng truy cập: Không được lập chỉ mục đồng nghĩa với việc không có lưu lượng truy cập tự nhiên (organic traffic), làm giảm tiềm năng kinh doanh và khả năng tiếp cận khách hàng.

- Ảnh hưởng đến uy tín website: Một website không được Google lập chỉ mục có thể bị coi là không đáng tin cậy hoặc không tồn tại, ảnh hưởng đến thương hiệu. Để khắc phục robots.txt chặn Googlebot, bạn cần hiểu rõ tầm quan trọng của nó.

- Lãng phí tài nguyên SEO: Mọi nỗ lực tối ưu hóa nội dung, xây dựng liên kết sẽ trở nên vô nghĩa nếu robots.txt chặn Googlebot không cho phép nó tiếp cận. Việc biết robots.txt chặn Googlebot phải làm sao giúp bạn bảo toàn các khoản đầu tư này.

Robots.txt chặn Googlebot phải làm sao khi đang đăng ký mã vạch sản phẩm?

Đối với một doanh nghiệp đang trong quá trình đăng ký mã vạch sản phẩm, việc website bị robots.txt chặn Googlebot là một rào cản lớn.

- Thông tin sản phẩm không được index: Các trang sản phẩm mới, thông tin về mã vạch, chứng nhận chất lượng sẽ không thể đến tay người dùng nếu robots.txt chặn Googlebot.

- Cạnh tranh gay gắt: Trong ngành đăng ký mã vạch sản phẩm, việc hiển thị nhanh chóng và chính xác trên Google là lợi thế cạnh tranh. Nếu robots.txt chặn Googlebot, bạn sẽ mất đi lợi thế đó.

- Thiếu thông tin cho khách hàng: Khách hàng sẽ không thể tìm thấy thông tin sản phẩm của bạn khi tìm kiếm, dẫn đến bỏ lỡ cơ hội bán hàng. Việc tìm hiểu robots.txt chặn Googlebot phải làm sao là cực kỳ quan trọng đối với các doanh nghiệp này.

Đảm bảo file robots.txt của bạn được cấu hình đúng là một phần không thể thiếu của chiến lược SEO tổng thể, đặc biệt khi bạn cần sự hiện diện mạnh mẽ trên công cụ tìm kiếm cho các sản phẩm đã đăng ký mã vạch sản phẩm. Đừng để robots.txt chặn Googlebot làm gián đoạn hành trình SEO của bạn.

Robots.txt chặn Googlebot phải làm sao đối với các loại Googlebot khác nhau và các công cụ tìm kiếm khác?

Khi nói về việc robots.txt chặn Googlebot, chúng ta thường nghĩ đến Googlebot chính. Tuy nhiên, Google có nhiều loại bot khác nhau và các công cụ tìm kiếm khác cũng có bot riêng. Vậy robots.txt chặn Googlebot phải làm sao cho từng trường hợp?

- Googlebot-Image, Googlebot-Video, Googlebot-News: Đây là các bot chuyên biệt của Google. Nếu bạn muốn chặn hình ảnh, video hoặc nội dung tin tức của mình xuất hiện trên các tìm kiếm chuyên biệt của Google, bạn có thể chỉ định

User-agent: Googlebot-ImagehoặcUser-agent: Googlebot-Videovà thêm lệnhDisallow. Tuy nhiên, nếu bạn muốn các nội dung này được lập chỉ mục, hãy đảm bảo không có lệnh Disallow nào dành cho chúng. Robots.txt chặn Googlebot có thể ảnh hưởng đến cả các loại bot này. - Bingbot, DuckDuckBot, YandexBot: Các công cụ tìm kiếm khác cũng có bot riêng của họ. Nếu bạn muốn kiểm soát quyền truy cập của các bot này, bạn cần thêm các

User-agenttương ứng vào file robots.txt của mình. Ví dụ:

User-agent: Bingbot

Disallow: /private/

Việc biết robots.txt chặn Googlebot phải làm sao cũng bao gồm việc hiểu cách nó ảnh hưởng đến các bot khác. - Tên miền phụ và thư mục phụ: Nếu bạn có tên miền phụ (subdomain) hoặc các thư mục phụ quan trọng, bạn cần đảm bảo rằng file robots.txt của chúng cũng được cấu hình chính xác. Đôi khi, một tệp robots.txt riêng biệt cho tên miền phụ có thể vô tình chặn Googlebot khỏi toàn bộ phần đó của trang web.

Robots.txt chặn Googlebot phải làm sao khi bạn không có file robots.txt hoặc file đó trống?

Nếu bạn kiểm tra và thấy mình không có file robots.txt hoặc file đó trống. Vậy robots.txt chặn Googlebot phải làm sao trong trường hợp này?

- Không có file robots.txt: Điều này có nghĩa là Googlebot và tất cả các công cụ tìm kiếm khác được phép thu thập thông tin toàn bộ website của bạn. Điều này không phải lúc nào cũng là vấn đề. Tuy nhiên, nếu bạn có các phần bạn không muốn Google index (ví dụ: trang quản trị, trang tạm thời), bạn sẽ cần tạo một file robots.txt và thêm các lệnh

Disallowphù hợp. - File robots.txt trống: Tương tự như việc không có file, một file robots.txt trống cũng có nghĩa là bot được phép thu thập thông tin mọi thứ.

Nếu bạn cần kiểm soát quyền truy cập của bot, hãy tạo một file văn bản có tên robots.txt và đặt nó vào thư mục gốc của website. Ví dụ, để cho phép tất cả các bot truy cập mọi thứ trong WordPress, bạn có thể chỉ cần:

User-agent: *

Allow: /

Sitemap: https://yourdomain.com/sitemap_index.xml

Thêm dòng Sitemap là một thực hành tốt để giúp Googlebot tìm thấy tất cả các trang quan trọng của bạn một cách dễ dàng, đặc biệt trong trường hợp robots.txt chặn Googlebot đã được giải quyết.

Robots.txt chặn Googlebot phải làm sao khi lỗi không nằm ở robots.txt?

Đôi khi, bạn có thể nghĩ rằng robots.txt chặn Googlebot, nhưng vấn đề thực sự nằm ở một nơi khác.

- Thẻ Meta Robots: Một trang có thể bị chặn lập chỉ mục bởi thẻ meta robots (

<meta name="robots" content="noindex, follow">) trong phần<head>của trang HTML. Thẻnoindexsẽ ngăn Googlebot lập chỉ mục trang đó, bất kể file robots.txt cho phép hay không. Việc biết robots.txt chặn Googlebot phải làm sao cũng bao gồm việc kiểm tra các yếu tố khác. - Xác thực mật khẩu: Nếu một trang hoặc thư mục được bảo vệ bằng mật khẩu (ví dụ: HTTP authentication), Googlebot sẽ không thể truy cập nó. Điều này cũng tương tự như việc robots.txt chặn Googlebot nhưng với một cơ chế khác.

- Sự cố kỹ thuật máy chủ: Các vấn đề về máy chủ như lỗi 5xx, thời gian phản hồi chậm, hoặc lỗi DNS có thể ngăn Googlebot truy cập trang web của bạn, khiến bạn nhầm tưởng robots.txt chặn Googlebot.

- Chặn địa chỉ IP: Đôi khi, nhà cung cấp hosting hoặc cài đặt tường lửa của bạn có thể vô tình chặn các địa chỉ IP của Googlebot.

Khi gặp vấn đề với việc Googlebot không index website, hãy kiểm tra toàn diện tất cả các yếu tố có thể ảnh hưởng đến khả năng tiếp cận của bot, không chỉ riêng file robots.txt. Nếu đã kiểm tra kỹ và vẫn nghi ngờ robots.txt chặn Googlebot, hãy nhờ sự hỗ trợ của chuyên gia SEO.

FAQ – Câu hỏi thường gặp về robots.txt chặn Googlebot phải làm sao

Q1: Robots.txt chặn Googlebot phải làm sao khi tôi không biết gì về code?

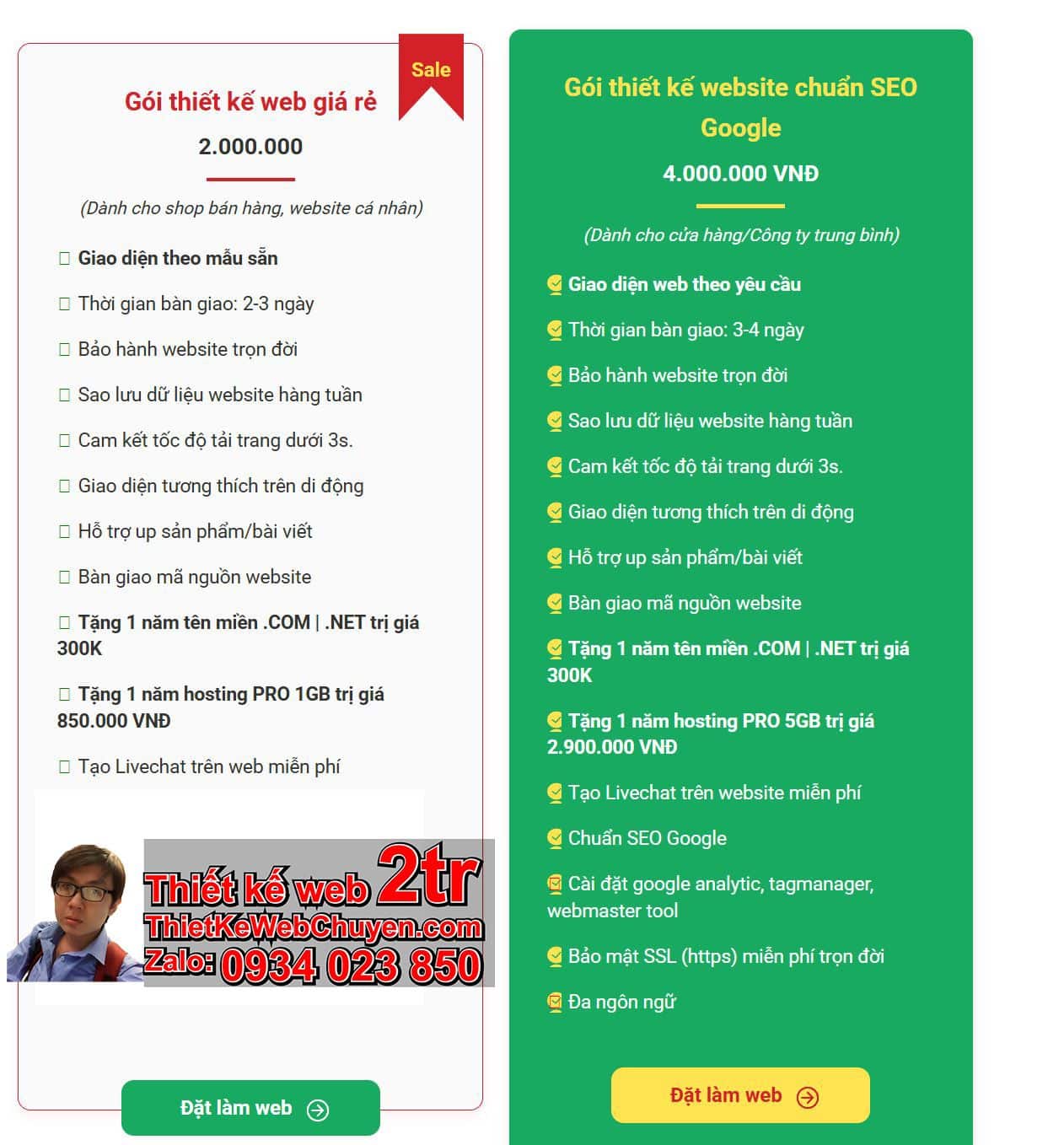

A1: Bạn không cần phải là một coder chuyên nghiệp để giải quyết vấn đề robots.txt chặn Googlebot. Hầu hết các CMS như WordPress đều có các plugin SEO (ví dụ: Yoast SEO, Rank Math) cho phép bạn chỉnh sửa file robots.txt một cách trực quan trong giao diện quản trị. Nếu bạn không dùng CMS, hãy tìm trợ giúp từ dịch vụ thiết kế web hoặc chuyên gia SEO.

Q2: Tôi có nên xóa hoàn toàn file robots.txt nếu robots.txt chặn Googlebot?

A2: Không nhất thiết. Xóa file robots.txt sẽ khiến Googlebot được phép truy cập tất cả các trang, bao gồm cả những trang bạn có thể không muốn nó lập chỉ mục (như trang đăng nhập hoặc trang cảm ơn). Tốt hơn là nên chỉnh sửa file robots.txt để chỉ cho phép truy cập những trang quan trọng và chặn đúng những trang không cần thiết.

Q3: Sau khi sửa lỗi robots.txt chặn Googlebot, mất bao lâu để Google index lại trang của tôi?

A3: Thời gian để Google index lại tùy thuộc vào nhiều yếu tố như độ uy tín của website, tần suất cập nhật nội dung và crawl rate của Googlebot. Thông thường, sau khi bạn yêu cầu lập chỉ mục lại trong Google Search Console, quá trình này có thể mất từ vài ngày đến vài tuần. Đối với các website mới thành lập hoặc ít được cập nhật, việc đưa web lên Google có thể lâu hơn.

Q4: Làm thế nào để kiểm tra xem robots.txt của tôi có bị lỗi hay không?

A4: Cách tốt nhất để kiểm tra là sử dụng công cụ “Trình kiểm tra tệp robots.txt” trong Google Search Console. Công cụ này sẽ chỉ ra bất kỳ lỗi cú pháp nào và cho bạn biết liệu một URL cụ thể có bị robots.txt chặn Googlebot hay không.

Q5: Robots.txt chặn Googlebot có ảnh hưởng đến SEO tổng thể không?

A5: Có, việc robots.txt chặn Googlebot là một trong những lỗi SEO nghiêm trọng nhất. Nó ngăn cản Google truy cập và lập chỉ mục nội dung của bạn, khiến trang web không thể xuất hiện trên kết quả tìm kiếm và làm giảm đáng kể lưu lượng truy cập tự nhiên. Do đó, việc giải quyết robots.txt chặn Googlebot phải làm sao là ưu tiên hàng đầu trong các vấn đề SEO kỹ thuật. Đặc biệt quan trọng với các doanh nghiệp đăng ký mã vạch sản phẩm và cần hiển thị sản phẩm của mình.

Q6: Khi nào thì tôi muốn robots.txt chặn Googlebot một số trang?

A6: Bạn có thể muốn robots.txt chặn Googlebot các trang sau:

- Trang quản trị (admin pages)

- Trang đăng nhập/đăng ký

- Các trang cảm ơn hoặc trang xác nhận đơn hàng (sau khi mua sắm)

- Các trang nội bộ không có giá trị đối với người dùng tìm kiếm

- Các bản staging/thử nghiệm của website

- Các tệp media không cần thiết (như các phiên bản nhỏ của hình ảnh, nhưng thường tốt hơn là để chúng được index nếu chúng là hình ảnh nội dung chính)

- Các trang có nội dung trùng lặp (tuy nhiên, thẻ canonical thường là giải pháp tốt hơn cho vấn đề này).

Q7: Nếu tôi sử dụng plugin SEO để chỉnh sửa robots.txt, tôi có cần làm gì khác không?

A7: Các plugin SEO như Yoast SEO hoặc Rank Math thường cung cấp giao diện thân thiện để chỉnh sửa file robots.txt. Sau khi chỉnh sửa, hãy lưu thay đổi trong plugin. Plugin sẽ tự động cập nhật file physical robots.txt trên máy chủ của bạn. Bạn vẫn nên kiểm tra lại bằng Google Search Console để đảm bảo sự thay đổi đã được áp dụng đúng cách và không có lỗi nào.

Nếu bạn gặp khó khăn trong việc khắc phục lỗi robots.txt chặn Googlebot hoặc cần trợ giúp tối ưu hóa website cho SEO, hãy liên hệ với chúng tôi tại ThietKeWebWio.com qua Zalo 0934 023 850 để được tư vấn và hỗ trợ chuyên nghiệp. Chúng tôi sẽ giúp bạn giải quyết các vấn đề kỹ thuật và đưa website của bạn lên top Google hiệu quả.

Bạn có thể tham khảo thêm các bài viết về cách đưa website lên Google tại đây:

robots.txt chặn Googlebot phải làm sao

robots.txt chặn Googlebot phải làm sao