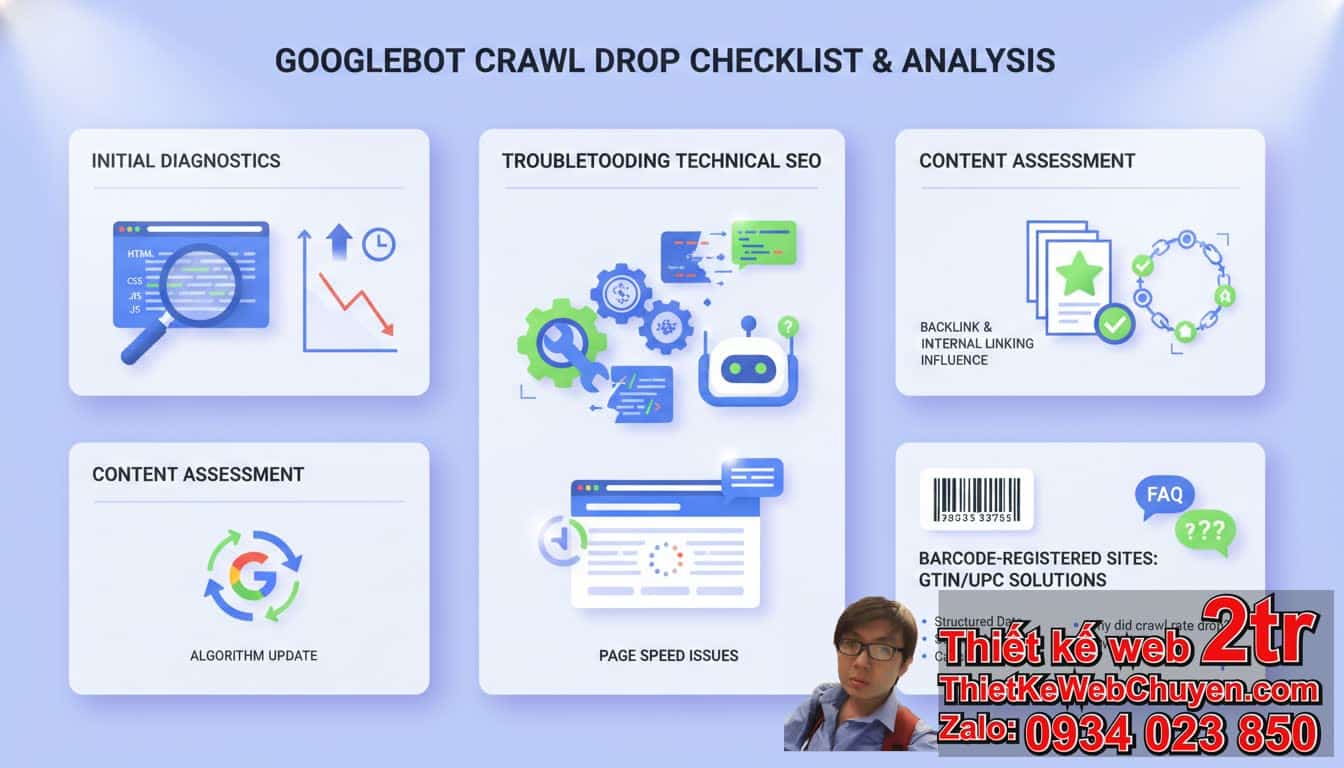

Googlebot crawl giảm mạnh phải làm sao? Hướng dẫn chi tiết cho website đăng ký mã vạch

Nếu Googlebot crawl giảm mạnh đột ngột, bạn cần hành động ngay lập tức để bảo vệ thứ hạng và hiển thị của website. Các bước ban đầu bao gồm kiểm tra Google Search Console, phân tích nhật ký máy chủ, sửa lỗi kỹ thuật, tối ưu hóa tốc độ tải trang và cải thiện chất lượng nội dung. Đặc biệt, với các website về đăng ký mã vạch sản phẩm, việc đảm bảo Googlebot hiểu rõ cấu trúc và nội dung là vô cùng quan trọng để thông tin sản phẩm của bạn đến được với người dùng.

Mục lục

- Googlebot crawl giảm mạnh phải làm sao: Tổng quan và các bước kiểm tra ban đầu

- Googlebot crawl giảm mạnh do vấn đề kỹ thuật SEO?

- Googlebot crawl giảm mạnh có liên quan đến chất lượng nội dung?

- Googlebot crawl giảm mạnh vì tốc độ trang web chậm?

- Googlebot crawl giảm mạnh và vai trò của Backlink, Internal Link

- Googlebot crawl giảm mạnh khi Google cập nhật thuật toán?

- Googlebot crawl giảm mạnh và cách khắc phục cho website đăng ký mã vạch

- FAQ: Những câu hỏi thường gặp khi Googlebot crawl giảm mạnh

1. Googlebot crawl giảm mạnh phải làm sao: Tổng quan và các bước kiểm tra ban đầu?

Khi bạn nhận thấy Googlebot crawl giảm mạnh, điều đầu tiên cần làm là giữ bình tĩnh và thực hiện một chuỗi kiểm tra có hệ thống. Việc Googlebot crawl giảm mạnh có thể xuất phát từ nhiều nguyên nhân khác nhau, từ lỗi kỹ thuật đến các yếu tố liên quan đến chất lượng nội dung và hiệu suất máy chủ.

1.1. Những dấu hiệu nhận biết Googlebot crawl giảm mạnh?

- Lượt truy cập tự nhiên từ Google giảm sút đáng kể.

- Số trang được lập chỉ mục (indexed pages) trong Google Search Console giảm.

- Biểu đồ lượt thu thập dữ liệu (crawl stats) trong Google Search Console cho thấy sự sụt giảm.

- Thông báo lỗi trong mục “Trang” (Pages) hoặc “Tập hợp chỉ mục” (Index Coverage) trong Google Search Console.

- Thời gian Googlebot truy cập trang web của bạn ít hơn.

- Số lượng từ khóa xếp hạng (ranking keywords) và vị trí của chúng bị ảnh hưởng.

1.2. Các bước kiểm tra ban đầu khi Googlebot crawl giảm mạnh là gì?

- Kiểm tra Google Search Console ngay lập tức: Đây là công cụ quan trọng nhất để theo dõi hoạt động thu thập dữ liệu của Googlebot.

- Xem mục “Cài đặt” (Settings) -> “Số liệu thống kê về thu thập dữ liệu” (Crawl stats) để xem biểu đồ số lượt thu thập dữ liệu và số lượng tài nguyên được thu thập.

- Kiểm tra mục “Trang” (Pages) để tìm bất kỳ lỗi lập chỉ mục nào, chẳng hạn như “Đã thu thập dữ liệu nhưng chưa lập chỉ mục” hoặc “Bị chặn bởi robots.txt”.

- Sử dụng công cụ “Công cụ kiểm tra URL” (URL Inspection Tool) để kiểm tra một số trang cụ thể và xem Googlebot đã thu thập dữ liệu như thế nào.

- Kiểm tra file robots.txt: Đảm bảo bạn không vô tình chặn Googlebot truy cập vào các phần quan trọng của trang web. Một số lỗi cấu hình nhỏ trong file robots.txt có thể khiến Googlebot crawl giảm mạnh.

- Kiểm tra sitemap.xml: Đảm bảo sitemap của bạn được cập nhật và không có lỗi. Sitemap giúp Googlebot dễ dàng khám phá các trang mới và quan trọng.

- Kiểm tra thông báo từ Google: Đôi khi Google sẽ gửi cảnh báo về các vấn đề nghiêm trọng qua Google Search Console hoặc email.

- Phân tích nhật ký máy chủ (Server Logs): Nếu có quyền truy cập, nhật ký máy chủ sẽ cho bạn biết chính xác thời điểm và tần suất Googlebot truy cập vào trang web của bạn. Đây là bằng chứng không thể chối cãi về việc Googlebot crawl giảm mạnh.

2. Googlebot crawl giảm mạnh do vấn đề kỹ thuật SEO?

Vấn đề kỹ thuật là một trong những nguyên nhân phổ biến nhất khiến Googlebot crawl giảm mạnh. Việc Googlebot gặp khó khăn khi truy cập hoặc xử lý trang web của bạn sẽ dẫn đến việc giảm tần suất thu thập dữ liệu.

2.1. Tại sao Googlebot crawl giảm mạnh vì cài đặt Robots.txt hoặc Meta Robots?

- Lỗi Robots.txt: Một dòng

Disallow: /không đúng chỗ trong file robots.txt có thể chặn toàn bộ website của bạn khỏi Googlebot, dẫn đến tình trạng Googlebot crawl giảm mạnh nghiêm trọng. - Thẻ Meta Robots “noindex” hoặc “nofollow”: Nếu bạn đặt thẻ

<meta name="robots" content="noindex, nofollow">trên các trang quan trọng, Googlebot sẽ không lập chỉ mục hoặc theo dõi liên kết từ các trang đó. Hãy kiểm tra mã nguồn của các trang bị ảnh hưởng. - Lỗi trong file .htaccess: Cấu hình sai trong file .htaccess có thể gây ra lỗi chuyển hướng vô hạn (redirect loops) hoặc chặn truy cập của Googlebot.

2.2. Googlebot crawl giảm mạnh có phải do lỗi cấu trúc URL và liên kết nội bộ?

- URL không thân thiện: Các URL quá dài, chứa ký tự đặc biệt hoặc không phản ánh nội dung có thể làm Googlebot khó hiểu và thu thập dữ liệu.

- Liên kết nội bộ bị hỏng (Broken Internal Links): Nhiều liên kết hỏng (404 Not Found) sẽ làm Googlebot mất nhiều thời gian hơn để thu thập dữ liệu và có thể dẫn đến Googlebot crawl giảm mạnh. Chúng gửi tín hiệu tiêu cực về chất lượng trang web.

- Liên kết nội bộ không hợp lý: Cấu trúc liên kết nội bộ (internal linking) kém, thiếu liên kết đến các trang quan trọng, hoặc các trang quan trọng bị “chôn vùi” quá sâu trong cấu trúc trang web sẽ khiến Googlebot bỏ qua.

- Sử dụng iframe, Flash, JavaScript phức tạp: Googlebot ngày càng giỏi xử lý JavaScript, nhưng việc sử dụng quá nhiều tài nguyên phức tạp chưa được tối ưu có thể làm chậm quá trình thu thập dữ liệu.

2.3. Các mã trạng thái HTTP (HTTP status codes) ảnh hưởng đến việc Googlebot crawl giảm mạnh như thế nào?

- Lỗi 4xx (Client Errors): Các lỗi như 404 Not Found (trang không tồn tại) hoặc 403 Forbidden (truy cập bị cấm) khi Googlebot cố gắng truy cập trang của bạn sẽ khiến Googlebot crawl giảm mạnh vì các trang này không có nội dung để lập chỉ mục.

- Lỗi 5xx (Server Errors): Các lỗi như 500 Internal Server Error (lỗi máy chủ nội bộ) hoặc 503 Service Unavailable (dịch vụ không khả dụng) là tín hiệu xấu cho Googlebot. Nếu Googlebot liên tục gặp lỗi máy chủ, nó sẽ giảm tần suất thu thập dữ liệu để tránh làm quá tải máy chủ của bạn.

- Chuyển hướng (Redirects): Chuỗi chuyển hướng quá dài hoặc chuyển hướng vòng lặp (redirect loops) có thể làm Googlebot tốn nhiều tài nguyên hơn và có thể dẫn đến việc Googlebot crawl giảm mạnh.

3. Googlebot crawl giảm mạnh có liên quan đến chất lượng nội dung?

Chất lượng nội dung đóng vai trò cực kỳ quan trọng trong việc giữ chân Googlebot và khuyến khích nó quay lại thường xuyên. Nếu nội dung của bạn không đáp ứng kỳ vọng, Googlebot crawl giảm mạnh là điều khó tránh khỏi.

3.1. Nội dung trùng lặp (Duplicate content) khiến Googlebot crawl giảm mạnh như thế nào?

- Nội dung trùng lặp nội bộ: Nhiều trang trên cùng một website có nội dung rất giống nhau (ví dụ: các trang sản phẩm chỉ khác nhau ở màu sắc hoặc kích thước mà không có nội dung mô tả độc đáo). Googlebot sẽ không muốn thu thập dữ liệu hoặc lập chỉ mục tất cả các trang này, dẫn đến Googlebot crawl giảm mạnh cho những trang đó.

- Nội dung trùng lặp bên ngoài: Lấy nội dung từ các website khác mà không có sự chỉnh sửa hoặc bổ sung giá trị. Google sẽ xem đây là nội dung kém chất lượng và giảm tần suất thu thập dữ liệu.

- Vấn đề với URL Canonicalization: Nếu không có thẻ “canonical” để chỉ định phiên bản URL ưu tiên, Googlebot có thể bối rối và làm giảm hiệu quả thu thập dữ liệu.

3.2. Nội dung mỏng, kém chất lượng có làm Googlebot crawl giảm mạnh không?

- Nội dung mỏng (Thin content): Các trang có rất ít văn bản, không cung cấp giá trị thông tin cho người dùng. Googlebot sẽ đánh giá thấp các trang này và ưu tiên các trang có nội dung phong phú hơn.

- Nội dung không liên quan hoặc spam: Các trang được tạo ra chỉ để nhồi nhét từ khóa hoặc chứa nội dung không hữu ích. Googlebot sẽ nhanh chóng nhận ra và giảm tần suất thu thập dữ liệu hoặc loại bỏ các trang này khỏi chỉ mục.

- Thiếu cập nhật nội dung: Trang web không có nội dung mới hoặc được cập nhật thường xuyên. Googlebot có xu hướng ưu tiên các website năng động, thường xuyên bổ sung thông tin mới. Nếu bạn đang cung cấp dịch vụ đăng ký mã vạch sản phẩm, việc cập nhật tin tức về quy định, hướng dẫn mới là rất quan trọng.

3.3. Googlebot crawl giảm mạnh khi thiếu trải nghiệm người dùng (UX) tốt?

- Thiết kế website lỗi thời, khó sử dụng: Trang web rối mắt, điều hướng khó khăn, người dùng cần nhấp quá nhiều lần để tìm thông tin. Googlebot càng ngày càng coi trọng trải nghiệm người dùng.

- Quá nhiều quảng cáo làm phiền: Quảng cáo che khuất nội dung, pop-up gây khó chịu. Trải nghiệm người dùng kém sẽ dẫn đến tỷ lệ thoát cao và tín hiệu tiêu cực cho Googlebot.

- Thiếu tính tương tác: Không có phần bình luận, chia sẻ mạng xã hội. Một website sống động sẽ khuyến khích Googlebot quay lại thường xuyên hơn.

4. Googlebot crawl giảm mạnh vì tốc độ trang web chậm?

Tốc độ tải trang là một yếu tố xếp hạng quan trọng, và nó cũng ảnh hưởng trực tiếp đến tần suất Googlebot thu thập dữ liệu. Nếu trang web của bạn tải chậm, Googlebot crawl giảm mạnh là điều tất yếu.

4.1. Tốc độ tải trang ảnh hưởng đến Googlebot crawl giảm mạnh như thế nào?

- Thời gian thu thập dữ liệu (Crawl budget): Mỗi website có một “ngân sách” thu thập dữ liệu nhất định. Nếu trang của bạn tải chậm, Googlebot sẽ tốn nhiều thời gian hơn để thu thập một trang, dẫn đến việc nó sẽ không thể thu thập được nhiều trang khác trong cùng một phiên. Điều này trực tiếp làm Googlebot crawl giảm mạnh.

- Trải nghiệm người dùng: Tốc độ tải trang chậm làm giảm trải nghiệm người dùng, tăng tỷ lệ thoát và gửi tín hiệu tiêu cực về chất lượng website.

- Ưu tiên của Google: Google luôn ưu tiên các website nhanh để mang lại trải nghiệm tốt nhất cho người dùng.

4.2. Các yếu tố chính làm chậm tốc độ trang web và khiến Googlebot crawl giảm mạnh?

- Hình ảnh không tối ưu: Kích thước file ảnh quá lớn, không nén, không sử dụng định dạng web hiện đại (WebP). Đây là nguyên nhân phổ biến nhất.

- Mã JavaScript và CSS không được tối ưu: Các file JavaScript và CSS quá lớn, không được nén, không được gộp, hoặc gây chặn hiển thị (render-blocking).

- Hosting kém chất lượng: Máy chủ phản hồi chậm, băng thông thấp, tài nguyên máy chủ hạn chế. Một hosting không tốt sẽ khiến Googlebot mất kiên nhẫn.

- Quá nhiều plugin/theme nặng: Đặc biệt với các nền tảng CMS như WordPress, việc cài đặt quá nhiều plugin hoặc sử dụng theme nặng có thể làm chậm đáng kể website.

- Cơ sở dữ liệu không được tối ưu: Cơ sở dữ liệu lớn, chứa nhiều dữ liệu rác, các truy vấn chậm.

- Thiếu bộ nhớ đệm (Caching): Không sử dụng các kỹ thuật caching hiệu quả để lưu trữ các phiên bản trang web tĩnh, giúp tải nhanh hơn cho người dùng và Googlebot.

Để khắc phục tình trạng này và tránh Googlebot crawl giảm mạnh, bạn cần tối ưu hình ảnh, nén mã, sử dụng cache và cân nhắc nâng cấp hosting.

5. Googlebot crawl giảm mạnh và vai trò của Backlink, Internal Link

Liên kết đóng vai trò huyết mạch trong việc giúp Googlebot khám phá và đánh giá các trang web. Khi lượng liên kết chất lượng giảm sút, bạn có thể thấy Googlebot crawl giảm mạnh.

5.1. Backlink chất lượng ảnh hưởng đến tần suất Googlebot crawl như thế nào?

- Tín hiệu đáng tin cậy: Backlink từ các trang web uy tín, có liên quan được xem là phiếu bầu tin cậy. Khi có nhiều backlink chất lượng, Googlebot sẽ coi trang của bạn là quan trọng và đáng tin cậy hơn, khuyến khích nó thu thập dữ liệu thường xuyên hơn.

- Khám phá trang mới: Backlink chất lượng giúp Googlebot tìm thấy các trang mới và nội dung cập nhật nhanh hơn, đặc biệt quan trọng cho các website cung cấp dịch vụ đăng ký mã vạch sản phẩm cần cập nhật thông tin liên tục.

- Tăng Crawl Budget: Một website có uy tín cao thường được Google cấp phát crawl budget (ngân sách thu thập dữ liệu) lớn hơn, giúp nó thu thập nhiều trang hơn.

5.2. Internal Link tối ưu giúp chống lại Googlebot crawl giảm mạnh như thế nào?

- Điều hướng Googlebot: Liên kết nội bộ mạch lạc giúp Googlebot dễ dàng ‘đi theo’ và khám phá tất cả các trang quan trọng trên website của bạn. Cấu trúc liên kết nội bộ tốt là chìa khóa để Googlebot không bỏ sót bất kỳ trang nào.

- Phân phối PageRank: Liên kết nội bộ giúp truyền sức mạnh (PageRank) giữa các trang, làm cho các trang “sâu” hơn vẫn nhận được tín hiệu mạnh mẽ từ Googlebot.

- Xác định độ ưu tiên: Bằng cách liên kết nhiều hơn đến các trang quan trọng (ví dụ: trang dịch vụ đăng ký mã vạch sản phẩm, trang liên hệ), bạn gửi tín hiệu cho Googlebot biết những trang nào có giá trị cao nhất.

- Giảm thiểu trang mồ côi (Orphan pages): Các trang không có bất kỳ liên kết nội bộ nào trỏ đến được gọi là trang mồ côi và Googlebot rất khó tìm thấy chúng. Điều này trực tiếp làm Googlebot crawl giảm mạnh đối với các trang đó.

5.3. Cách kiểm tra và tối ưu liên kết để tránh Googlebot crawl giảm mạnh?

- Tìm kiếm Broken Links: Sử dụng các công cụ như Google Search Console (mục “Trang”), Screaming Frog, Ahrefs để tìm và sửa chữa các liên kết hỏng.

- Xây dựng chiến lược Internal Linking: Liên kết các bài viết liên quan, trang sản phẩm/dịch vụ có liên quan. Đảm bảo mọi trang quan trọng đều có ít nhất một liên kết nội bộ trỏ đến.

- Theo dõi Backlink Profile: Kiểm tra các backlink mới và mất đi. Giảm thiểu các backlink kém chất lượng hoặc spam có thể gây hại.

- Vị trí và anchor text: Đặt liên kết nội bộ ở những vị trí nổi bật và sử dụng anchor text mô tả, chứa từ khóa liên quan.

6. Googlebot crawl giảm mạnh khi Google cập nhật thuật toán?

Các bản cập nhật thuật toán của Google có thể gây ra những thay đổi lớn về cách Googlebot thu thập dữ liệu và xếp hạng các trang web. Việc Googlebot crawl giảm mạnh có thể là một phản ứng trực tiếp với những thay đổi này.

6.1. Google Core Updates và tác động đến tần suất Googlebot crawl?

- Thay đổi tiêu chí đánh giá: Các Core Updates thường tập trung vào việc cải thiện cách Google đánh giá chất lượng nội dung, trải nghiệm người dùng và mức độ tin cậy của website. Nếu trang web của bạn không đáp ứng các tiêu chí mới, Googlebot có thể giảm tần suất thu thập dữ liệu.

- Ưu tiên các website chất lượng cao: Sau các bản cập nhật lớn, Google có xu hướng ưu tiên các website được đánh giá cao hơn về chất lượng và độ tin cậy. Điều này có thể khiến Googlebot crawl giảm mạnh đối với các website kém chất lượng hơn.

- Hiểu rõ ý định tìm kiếm: Các thuật toán mới giúp Google hiểu rõ hơn ý định tìm kiếm của người dùng. Nếu nội dung của bạn không còn đáp ứng tốt các ý định này, Googlebot có thể ít quan tâm hơn.

6.2. Các bản cập nhật liên quan đến Spam Content và những ảnh hưởng đến Googlebot crawl giảm mạnh?

- Thắt chặt quy định về Spam: Google liên tục cập nhật để chống lại các loại spam, bao gồm nội dung được tạo tự động, nhồi nhét từ khóa, nội dung copy Paste.

- “De-crawling” các trang spam: Nếu website của bạn bị xác định là có chứa nội dung spam, Googlebot có thể hoàn toàn ngừng thu thập dữ liệu các trang đó hoặc giảm tần suất thu thập dữ liệu xuống mức thấp nhất, dẫn đến Googlebot crawl giảm mạnh nghiêm trọng.

- Tăng cường đánh giá E-E-A-T: Các bản cập nhật cũng nhấn mạnh tầm quan trọng của Expertise, Experience, Authoritativeness, and Trustworthiness. Một website thiếu các yếu tố này có thể bị Googlebot ít chú ý hơn.

6.3. Làm thế nào để đối phó khi Googlebot crawl giảm mạnh do thuật toán?

- Theo dõi cập nhật của Google: Luôn cập nhật thông tin về các bản cập nhật thuật toán của Google thông qua các blog SEO uy tín.

- Tập trung vào chất lượng và người dùng: Sau mỗi bản cập nhật, điều quan trọng nhất là đánh giá lại nội dung của bạn xem nó có thực sự hữu ích, đáng tin cậy và mang lại trải nghiệm tốt cho người dùng hay không.

- Kiểm tra kỹ thuật SEO: Đảm bảo tất cả các yếu tố kỹ thuật SEO của bạn đều được tối ưu, không có lỗi.

- Đa dạng hóa nguồn traffic: Không phụ thuộc hoàn toàn vào Google Search. Cân nhắc các nguồn traffic khác như mạng xã hội, email marketing, quảng cáo.

7. Googlebot crawl giảm mạnh và cách khắc phục cho website đăng ký mã vạch

Đối với một website chuyên về đăng ký mã vạch sản phẩm, việc Googlebot crawl giảm mạnh có thể ảnh hưởng nghiêm trọng đến khả năng hiển thị thông tin quan trọng về sản phẩm và dịch vụ của bạn.

7.1. Các bước cụ thể để khắc phục khi Googlebot crawl giảm mạnh cho website đăng ký mã vạch:

- Kiểm tra ngay Google Search Console:

- Xem “Số liệu thống kê về thu thập dữ liệu” để xác nhận Googlebot crawl giảm mạnh.

- Kiểm tra “Trang” và “Khả năng sử dụng trên thiết bị di động” để tìm lỗi.

- Sử dụng “Công cụ kiểm tra URL” cho các trang sản phẩm hoặc trang dịch vụ đăng ký mã vạch quan trọng.

- Rà soát toàn bộ cấu trúc website và Robots.txt:

- Đảm bảo không chặn các thư mục chứa thông tin sản phẩm, hướng dẫn đăng ký mã vạch.

- Kiểm tra các thẻ meta robots trên từng trang.

- Tối ưu tốc độ tải trang:

- Nén hình ảnh sản phẩm và các biểu đồ minh họa quy trình đăng ký mã vạch.

- Sử dụng bộ nhớ đệm (caching) và CDN.

- Kiểm tra hosting và cân nhắc nâng cấp nếu cần.

- Cải thiện chất lượng và độc đáo của nội dung:

- Mỗi trang sản phẩm hoặc dịch vụ đăng ký mã vạch phải có mô tả độc đáo, chi tiết, không trùng lặp.

- Cung cấp các bài viết hướng dẫn chi tiết, FAQ về mã vạch sản phẩm, lợi ích của việc đăng ký mã vạch, quy trình thực hiện, v.v. Điều này không chỉ thu hút Googlebot mà còn giúp người dùng.

- Cập nhật thường xuyên các thông tin về quy định, luật pháp liên quan đến mã vạch.

- Đảm bảo nội dung trả lời đầy đủ các câu hỏi của người dùng khi tìm kiếm về đăng ký mã vạch.

- Xây dựng liên kết nội bộ chặt chẽ:

- Liên kết các trang dịch vụ đăng ký mã vạch với các bài viết hướng dẫn, tin tức liên quan.

- Tạo các danh mục, tag hợp lý để Googlebot dễ dàng điều hướng.

- Đảm bảo các trang quan trọng nhất (trang chủ, trang dịch vụ chính) có nhiều liên kết nội bộ trỏ về.

- Tối ưu hóa cho thiết bị di động:

- Website phải thân thiện với mobile. Googlebot ưu tiên lập chỉ mục các phiên bản di động.

- Tạo và gửi Sitemap XML rõ ràng:

- Đảm bảo sitemap chứa tất cả các URL quan trọng và được cập nhật mỗi khi có bài viết hoặc sản phẩm mới về mã vạch.

- Gửi lại sitemap trong Google Search Console.

- Tập trung vào E-E-A-T (Expertise, Experience, Authoritativeness, and Trustworthiness):

- Hiển thị rõ ràng thông tin liên hệ, chứng nhận, giấy phép kinh doanh (nếu có) để tăng độ tin cậy.

- Đăng tải các case study, testimonials của khách hàng đã sử dụng dịch vụ đăng ký mã vạch của bạn.

- Xây dựng danh tiếng trong ngành mã vạch sản phẩm thông qua content chất lượng và các hoạt động PR.

- Theo dõi và đánh giá thường xuyên:

- Sau khi thực hiện các thay đổi, hãy theo dõi sát sao biểu đồ lượt thu thập dữ liệu và báo cáo lập chỉ mục trong Google Search Console.

- Sử dụng các công cụ phân tích để đánh giá hiệu quả của các thay đổi.

7.2. Các công cụ cần sử dụng để khắc phục Googlebot crawl giảm mạnh?

- Google Search Console: Bắt buộc để theo dõi crawl stats, lập chỉ mục, lỗi trang.

- Google PageSpeed Insights: Kiểm tra tốc độ tải trang và nhận gợi ý tối ưu.

- Screaming Frog: Công cụ crawl website để phát hiện lỗi kỹ thuật, broken links, thin content.

- Log file analyzer (phân tích nhật ký máy chủ): Để xem chi tiết hành vi của Googlebot.

- Ahrefs/Semrush: Để phân tích backlink, nghiên cứu từ khóa, theo dõi xếp hạng.

8. FAQ: Những câu hỏi thường gặp khi Googlebot crawl giảm mạnh

Q1: Googlebot crawl giảm mạnh có phải là dấu hiệu bị phạt (manual penalty)?

Không nhất thiết. Mặc dù Googlebot crawl giảm mạnh có thể đi kèm với hình phạt thủ công, nhưng nó cũng có thể do nhiều nguyên nhân khác như lỗi kỹ thuật, nội dung kém chất lượng hoặc thay đổi thuật toán. Hãy kiểm tra mục “Bảo mật và thao tác thủ công” (Security & Manual Actions) trong Google Search Console. Nếu có hình phạt, bạn sẽ thấy thông báo ở đó.

Q2: Tôi có thể yêu cầu Googlebot ghé thăm lại trang web của mình không?

Có. Trong Google Search Console, bạn có thể sử dụng công cụ “Kiểm tra URL” (URL Inspection Tool) và yêu cầu lập chỉ mục (Request Indexing) cho từng URL cụ thể. Tuy nhiên, việc này chỉ nên làm sau khi bạn đã khắc phục các vấn đề gốc rễ khiến Googlebot crawl giảm mạnh.

Q3: Sau khi khắc phục các lỗi, bao lâu thì tần suất Googlebot crawl trở lại bình thường?

Thời gian có thể khác nhau tùy thuộc vào mức độ nghiêm trọng của vấn đề và kích thước website của bạn. Đối với các lỗi nhỏ, bạn có thể thấy sự cải thiện trong vài ngày đến vài tuần. Đối với các vấn đề lớn hoặc xử lý hình phạt, có thể mất vài tuần đến vài tháng. Điều quan trọng là liên tục theo dõi báo cáo crawl stats trong Google Search Console.

Q4: Crawl budget là gì và nó liên quan thế nào khi Googlebot crawl giảm mạnh?

Crawl budget là số lượng tài nguyên (thời gian và sức mạnh máy chủ) mà Googlebot phân bổ để thu thập dữ liệu website của bạn trong một khoảng thời gian nhất định. Nếu trang web của bạn có nhiều vấn đề kỹ thuật, tải chậm, hoặc chất lượng thấp, Googlebot sẽ “lãng phí” ngân sách này, dẫn đến việc ít trang được thu thập dữ liệu hơn và tần suất Googlebot crawl giảm mạnh. Tối ưu hóa website giúp Googlebot sử dụng crawl budget hiệu quả hơn.

Q5: Tại sao việc theo dõi nhật ký máy chủ lại quan trọng khi Googlebot crawl giảm mạnh?

Nhật ký máy chủ cung cấp dữ liệu chính xác nhất về các yêu cầu từ Googlebot đến máy chủ của bạn. Bạn có thể thấy:

- Tần suất Googlebot truy cập.

- Các URL cụ thể mà Googlebot đã truy cập.

- Các mã trạng thái HTTP (200 OK, 404 Not Found, 500 Internal Server Error) mà Googlebot nhận được.

- Loại Googlebot (ảnh, video, web).

Phân tích nhật ký giúp bạn xác định các vấn đề mà Google Search Console có thể không hiển thị rõ ràng, chẳng hạn như Googlebot bị chặn ở mức máy chủ, gây ra tình trạng Googlebot crawl giảm mạnh.

Hy vọng bài viết này đã cung cấp cho bạn những thông tin cần thiết về vấn đề Googlebot crawl giảm mạnh phải làm sao và các giải pháp khắc phục hiệu quả. Nếu bạn cần hỗ trợ về tối ưu SEO hoặc phát triển website chuyên nghiệp, đừng ngần ngại liên hệ với chúng tôi tại ThietKeWebWio.com Zalo 0934 023 850.

Để tìm hiểu thêm về cách đưa website lên Google và cải thiện hiệu suất SEO, bạn có thể tham khảo các bài viết sau: