Cách sửa robots.txt để Google crawl hiệu quả cho website đăng ký mã vạch sản phẩm

Để sửa robots.txt để Google crawl trang web đăng ký mã vạch sản phẩm của bạn một cách tối ưu, bạn cần đảm bảo tệp robots.txt không chặn các trình thu thập thông tin của Google truy cập vào những nội dung quan trọng. Điều này bao gồm việc cho phép Googlebot truy cập các trang sản phẩm, trang đăng ký, và các tài nguyên quan trọng khác, đồng thời chặn các trang không cần thiết hoặc nhạy cảm để tối ưu hóa quá trình thu thập dữ liệu và lập chỉ mục.

Mục lục

- Làm thế nào để kiểm tra và xác định lỗi trong robots.txt?

- Cách sửa robots.txt để Google crawl các trang sản phẩm và đăng ký mã vạch?

- Làm cách nào để chặn những nội dung không mong muốn khỏi Google crawl?

- Các phương pháp nào giúp tối ưu hóa robots.txt để tăng cường crawlability?

- Câu hỏi thường gặp về cách sửa robots.txt để Google crawl hiệu quả.

Làm thế nào để kiểm tra và xác định lỗi trong robots.txt?

Việc kiểm tra robots.txt là bước đầu tiên và quan trọng nhất để đảm bảo Google có thể crawl trang web của bạn mà không gặp trở ngại. Các lỗi trong tệp robots.txt có thể ngăn chặn Googlebot truy cập những phần quan trọng của trang web, dẫn đến việc giảm khả năng hiển thị trên công cụ tìm kiếm.

Xác định vị trí tệp robots.txt ở đâu?

Tệp robots.txt luôn nằm ở thư mục gốc của tên miền của bạn. Ví dụ: https://thietkewebwio.com/robots.txt. Nếu bạn không thể tìm thấy tệp này, có thể trang web của bạn chưa có nó, hoặc nó đã bị xóa. Trong trường hợp này, bạn cần tạo tệp robots.txt mới.

Sử dụng công cụ kiểm tra robots.txt trong Google Search Console

Đây là công cụ mạnh mẽ nhất để kiểm tra robots.txt của bạn.

- Đăng nhập vào Google Search Console: Chọn tài sản trang web của bạn.

- Truy cập Báo cáo “Công cụ kiểm tra robots.txt”: Bạn sẽ thấy mục này trong phần “Cài đặt” hoặc “Chỉ mục” (tùy thuộc vào phiên bản Search Console).

- Nhập URL cần kiểm tra: Nhập các URL quan trọng của trang web (ví dụ: trang sản phẩm, trang đăng ký mã vạch, trang liên hệ) để xem liệu Googlebot có bị chặn hay không.

- Phân tích kết quả:

- “Được phép” (Allowed): Tốt, Googlebot có thể truy cập URL này.

- “Bị chặn” (Blocked): Có vấn đề. Tệp robots.txt của bạn đang ngăn Googlebot truy cập URL này. Bạn cần sửa robots.txt để Google crawl được URL này.

Kiểm tra các quy tắc Disallow không mong muốn

Một trong những lỗi phổ biến nhất khi robots.txt chặn Google crawl là có các quy tắc Disallow không chính xác.

- Kiểm tra các dòng

Disallow: /hoặcDisallow: /wp-admin/(nếu bạn muốn người khác truy cập trang quản trị) trong tệp robots.txt. DòngDisallow: /sẽ chặn toàn bộ trang web của bạn khỏi việc Google crawl. - Hãy chắc chắn rằng không có quy tắc

Disallownào chặn các thư mục chứa sản phẩm hoặc thông tin đăng ký mã vạch của bạn. Ví dụ, nếu các trang sản phẩm của bạn nằm trong/san-pham/, bạn không nên cóDisallow: /san-pham/. - Ví dụ về quy tắc

Disallowcó thể gây hại:

User-agent: *

Disallow: /

Quy tắc này sẽ chặn mọi trình thu thập thông tin khỏi toàn bộ trang web.

User-agent: Googlebot

Disallow: /dang-ky-ma-vach/

Quy tắc này sẽ ngăn Googlebot truy cập các trang đăng ký mã vạch, điều này chắc chắn không tốt cho trang web của bạn.

Kiểm tra cú pháp lỗi

Các lỗi cú pháp nhỏ trong robots.txt cũng có thể gây ra vấn đề.

- Mỗi quy tắc (User-agent, Disallow, Allow, Sitemap) phải nằm trên một dòng riêng.

- Không có khoảng trắng thừa hoặc ký tự lạ.

- Tên User-agent phải chính xác (ví dụ:

Googlebot,Bingbot).

Bằng việc thực hiện các bước kiểm tra này, bạn có thể dễ dàng xác định các vấn đề ảnh hưởng đến khả năng Google crawl trang web của bạn và biết cách sửa robots.txt để Google crawl hiệu quả hơn.

Cách sửa robots.txt để Google crawl các trang sản phẩm và đăng ký mã vạch?

Để sửa robots.txt để Google crawl các trang sản phẩm và đăng ký mã vạch trên website của bạn, mục tiêu chính là đảm bảo không có quy tắc nào vô tình chặn Googlebot truy cập các nội dung quan trọng này. Quá trình này đòi hỏi sự chính xác để tối ưu hóa quy trình thu thập dữ liệu của Google.

Bước 1: Quyết định bạn muốn chặn hay cho phép điều gì

Trước khi chỉnh sửa, hãy lập danh sách tất cả các loại trang trên website của bạn và xác định:

- Những trang cần Google crawl và lập chỉ mục: Trang sản phẩm, trang chi tiết mã vạch, trang đăng ký dịch vụ, trang giới thiệu, trang liên hệ, bài viết blog liên quan đến mã vạch, v.v.

- Những trang không cần (hoặc không nên) Google crawl: Trang quản trị (ví dụ:

/wp-admin/), trang kết quả tìm kiếm nội bộ, trang giỏ hàng (nếu không muốn hiển thị trên kết quả tìm kiếm), trang đăng nhập/đăng ký người dùng (trừ khi là trang đăng ký dịch vụ chính), các thư mục chứa tài nguyên riêng tư, v.v.

Bước 2: Chỉnh sửa tệp robots.txt của bạn

Bạn có thể chỉnh sửa tệp robots.txt bằng bất kỳ trình soạn thảo văn bản nào (Notepad, Sublime Text, VS Code) hoặc thông qua FTP/Trình quản lý tệp của hosting.

Cho phép Googlebot truy cập toàn bộ trang web (trừ các phần cụ thể)

Đây là cách tiếp cận phổ biến và an toàn nhất để sửa robots.txt để Google crawl mà không gặp vấn đề.

User-agent: *

Allow: /

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /cgi-bin/

Disallow: /private/

Disallow: *.php$

Disallow: /*?

Sitemap: https://thietkewebwio.com/sitemap_index.xml

Giải thích các quy tắc:

User-agent: *: Quy tắc này áp dụng cho TẤT CẢ các bot của công cụ tìm kiếm (bao gồm Googlebot, Bingbot, v.v.). Đây là cách hiệu quả nhất để sửa robots.txt để Google crawl tất cả các bot mà không cần liệt kê riêng từng cái.Allow: /: Cho phép tất cả các bot truy cập MỌI THỨ trên trang web. Đây là dòng quan trọng nhất để sửa robots.txt để Google crawl nội dung của bạn.Disallow: /wp-admin/: Chặn Googlebot truy cập thư mục quản trị WordPress.Disallow: /wp-includes/: Chặn Googlebot truy cập các tệp nội bộ của WordPress.Disallow: /cgi-bin/: Chặn các thư mục script.Disallow: /private/: Chặn các thư mục riêng tư.Disallow: *.php$: Chặn các tệp .php (nếu bạn không muốn các tệp PHP cụ thể được lập chỉ mục, ví dụ các tệp xử lý backend).Disallow: /*?: Chặn các URL có tham số truy vấn (query parameters) để tránh nội dung trùng lặp, ví dụ:domain.com/san-pham/?color=red.Sitemap: https://thietkewebwio.com/sitemap_index.xml: Khai báo vị trí sitemap XML của bạn, giúp Googlebot tìm thấy tất cả các trang quan trọng nhanh hơn, đây là một phần quan trọng để tối ưu hóa quy trình thu thập dữ liệu.

Đảm bảo các trang sản phẩm và đăng ký mã vạch không bị chặn

Kiểm tra kỹ lưỡng để chắc chắn rằng không có lệnh Disallow nào vô tình chặn đường dẫn đến các trang này.

- Nếu đường dẫn sản phẩm của bạn là

/san-pham/abc, và đường dẫn đăng ký là/dang-ky-ma-vach/, thì hãy đảm bảo không có dòngDisallow: /san-pham/hoặcDisallow: /dang-ky-ma-vach/. - Nếu bạn có các thư mục cụ thể cho từng loại sản phẩm hoặc dịch vụ mã vạch, hãy kiểm tra từng thư mục đó.

Ví dụ cụ thể cho trang đăng ký mã vạch

Nếu bạn có cấu trúc URL như sau:

- Trang sản phẩm:

https://thietkewebwio.com/san-pham/ten-san-pham-a - Trang đăng ký mã vạch:

https://thietkewebwio.com/dang-ky-ma-vach/ - Trang quản lý tài khoản người dùng:

https://thietkewebwio.com/tai-khoan-cua-toi/(có thể muốn chặn)

Tệp robots.txt tối ưu có thể trông như sau:

User-agent: *

Allow: /

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /tai-khoan-cua-toi/

Disallow: /search/

Disallow: /*?action=

Disallow: /*?param=

Sitemap: https://thietkewebwio.com/sitemap_index.xmlUser-agent: Googlebot

Allow: /san-pham/

Allow: /dang-ky-ma-vach/

Lưu ý: Dòng Allow: /san-pham/ và Allow: /dang-ky-ma-vach/ dưới User-agent: Googlebot là không cần thiết nếu bạn đã có Allow: / chung cho tất cả bot. Tuy nhiên, nếu bạn có các Disallow cụ thể cho các thư mục con trong một User-agent khác, việc chỉ định Allow cụ thể cho Googlebot có thể giúp đảm bảo. Trong hầu hết các trường hợp, Allow: / tổng quát là đủ.

Bước 3: Tải lên tệp robots.txt đã chỉnh sửa

Sau khi chỉnh sửa, lưu tệp với tên robots.txt (đảm bảo không có đuôi .txt khác như robots.txt.txt) và tải nó lên thư mục gốc của trang web (cùng cấp với thư mục wp-content nếu dùng WordPress). Điều này rất quan trọng để sửa robots.txt để Google crawl có hiệu lực.

Bước 4: Kiểm tra lại bằng Google Search Console

Sau khi tải lên, quay lại Google Search Console và sử dụng “Công cụ kiểm tra robots.txt” để xác nhận rằng các trang sản phẩm và đăng ký mã vạch hiện đã được “Allowed”.

Việc biết cách sửa robots.txt để Google crawl một cách chính xác là cực kỳ quan trọng đối với SEO tổng thể website của bạn. Một tệp robots.txt được cấu hình đúng sẽ giúp Googlebot thu thập thông tin các trang quan trọng hiệu quả, cải thiện thứ hạng và hiển thị trên Google.

Làm cách nào để chặn những nội dung không mong muốn khỏi Google crawl?

Việc chặn các nội dung không mong muốn khỏi Google crawl là một phần quan trọng của việc tối ưu hóa SEO và quản lý tài nguyên crawl. Mặc dù bạn muốn sửa robots.txt để Google crawl những nội dung quan trọng, bạn cũng cần ngăn chặn Googlebot khỏi việc truy cập và lập chỉ mục các trang không cần thiết, nhạy cảm hoặc gây trùng lặp nội dung. Điều này giúp Google tập trung vào các trang có giá trị, đồng thời cải thiện hiệu suất crawl của trang web.

Xác định các loại nội dung cần chặn

Trước khi triển khai các quy tắc Disallow, hãy liệt kê rõ ràng những loại trang mà bạn không muốn Google crawl:

- Các trang quản trị và cấu hình: Ví dụ:

/wp-admin/,/backend/,/cpanel/. - Các trang đăng nhập/đăng ký người dùng: Trừ khi đó là trang đăng ký dịch vụ chính, các trang này thường không mang lại giá trị SEO. Ví dụ:

/dang-nhap/,/register/. - Các trang giỏ hàng và thanh toán: Trừ khi muốn hiển thị các sản phẩm trong giỏ hàng (hiếm), các trang này thường không cần lập chỉ mục. Ví dụ:

/gio-hang/,/thanh-toan/. - Các trang kết quả tìm kiếm nội bộ: Các trang này thường tạo ra nội dung trùng lặp và không có giá trị cho SEO bên ngoài. Ví dụ:

/search?q=,/tim-kiem/. - Các thư mục chứa tệp hệ thống hoặc tệp nhạy cảm: Ví dụ:

/wp-includes/,/cgi-bin/,/temp/, các thư mục chứa ảnh riêng tư hoặc tài liệu nội bộ. - Các trang có tham số URL (query parameters) vô nghĩa: Các URL như

/san-pham?sort=price_asc&filter=colorcó thể tạo ra vô số biến thể của cùng một nội dung, gây ra vấn đề trùng lặp. - Các trang phân trang không chuẩn (nếu có): Mặc dù phân trang thường được crawl, nhưng nếu có các lỗi hoặc cấu hình không đúng, có thể cần xem xét chặn.

- Các trang tạm thời hoặc đang phát triển: Các trang đang trong quá trình xây dựng hoặc thử nghiệm.

Sử dụng quy tắc Disallow trong robots.txt

Quy tắc Disallow: là cách chính để chặn Google crawl các đường dẫn cụ thể.

1. Chặn toàn bộ một thư mục

Để chặn toàn bộ một thư mục, bạn chỉ cần chỉ định đường dẫn thư mục đó.

Ví dụ:

User-agent: *

Disallow: /wp-admin/

Disallow: /gio-hang/

Disallow: /tai-khoan-cua-toi/

Quy tắc Disallow: /wp-admin/ sẽ chặn truy cập vào tất cả các URL bắt đầu bằng /wp-admin/, ví dụ: domain.com/wp-admin/index.php, domain.com/wp-admin/profile.php, v.v.

2. Chặn một tệp cụ thể

Bạn có thể chặn một tệp cụ thể bằng cách chỉ định đường dẫn tệp đó.

Ví dụ:

User-agent: *

Disallow: /private/secret.pdf

Disallow: /temp/test_image.jpg

3. Chặn các URL có tham số truy vấn (query parameters)

Đây là một kỹ thuật quan trọng để tránh nội dung trùng lặp do các URL có ký tự ?.

User-agent: *

Disallow: /*?

Quy tắc này chặn BẤT KỲ URL NÀO có ký tự ? theo sau là các ký tự khác (ví dụ: domain.com/san-pham?color=red, domain.com/blog?page=2).

Lưu ý: Quy tắc này có thể rất mạnh mẽ và đôi khi chặn cả các URL bạn muốn crawl (ví dụ: các URL có tham số phiên). Hãy kiểm tra kỹ bằng Google Search Console sau khi áp dụng.

Để chỉ chặn các tham số cụ thể, bạn có thể sử dụng dấu * (ký tự đại diện):

User-agent: *

Disallow: /*?color=*

Disallow: /*?sort=*

Quy tắc này sẽ chặn các URL có tham số color hoặc sort, nhưng vẫn cho phép các URL có tham số khác nếu chúng không bị chặn bởi quy tắc chung.

4. Chặn các tệp có phần mở rộng cụ thể

Sử dụng dấu $ để chỉ định “kết thúc bằng”.

User-agent: *

Disallow: /*.zip$

Disallow: /*.pdf$

Quy tắc này sẽ chặn tất cả các tệp .zip và .pdf trên toàn bộ trang web.

Lưu ý: Nếu bạn muốn các tài liệu PDF được lập chỉ mục (ví dụ: hướng dẫn sử dụng sản phẩm), bạn không nên chặn chúng. Hãy cân nhắc kỹ trước khi áp dụng quy tắc này khi sửa robots.txt để Google crawl.

Ví dụ tổng hợp về chặn nội dung cho website đăng ký mã vạch

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /cgi-bin/

Disallow: /template/

Disallow: /dang-nhap/

Disallow: /tai-khoan-cua-toi/

Disallow: /gio-hang/

Disallow: /thanh-toan/

Disallow: /search/

Disallow: /*?s=* # Chặn các URL tìm kiếm nội bộ có tham số 's'

Disallow: /*?sort=* # Chặn các URL có tham số sắp xếp

Disallow: /*?filter=* # Chặn các URL có tham số bộ lọc

Disallow: /*.css$ # Chặn các tệp CSS (thường không cần thiết nhưng đôi khi hữu ích cho các bot không hiển thị)

Disallow: /*.js$ # Chặn các tệp JavaScript (tương tự như CSS)User-agent: Googlebot

Disallow: /private-docs/ # Chỉ chặn Googlebot khỏi tài liệu riêng tư này

Sitemap: https://thietkewebwio.com/sitemap_index.xml

Sử dụng thẻ meta robots noindex thay vì robots.txt

Điều quan trọng cần hiểu là robots.txt chỉ ngăn chặn Googlebot CRAWL một trang, nó không ngăn chặn trang đó xuất hiện trong kết quả tìm kiếm nếu có các backlink mạnh mẽ trỏ về nó. Để chắc chắn một trang KHÔNG BAO GIỜ xuất hiện trong kết quả tìm kiếm, bạn nên sử dụng thẻ meta robots noindex trong phần <head> của trang đó:

<meta name="robots" content="noindex, follow">

Điều này hướng dẫn Googlebot lập chỉ mục trang nhưng không hiển thị nó trong kết quả tìm kiếm. Nếu bạn muốn chặn hoàn toàn cả crawl và lập chỉ mục, hãy sử dụng robots.txt cho các trang không quan trọng và meta noindex cho các trang mà Googlebot vẫn được phép truy cập nhưng bạn không muốn hiển thị.

Khi nào nên dùng robots.txt, khi nào nên dùng noindex?

- robots.txt: Dùng để chặn các tài nguyên không quan trọng, các thư mục lớn, hoặc các tệp mà bạn không muốn Googlebot lãng phí tài nguyên crawl vào. Nó không đảm bảo trang không bị lập chỉ mục.

- meta noindex: Dùng để chắc chắn một trang sẽ không xuất hiện trong kết quả tìm kiếm, ngay cả khi Googlebot có thể crawl nó. Meta noindex yêu cầu Googlebot phải truy cập trang.

- Kết hợp: Đối với các trang nhạy cảm hoặc không quan trọng, nhưng bạn muốn chắc chắn không xuất hiện trên Google, bạn có thể chặn bằng robots.txt (để tiết kiệm tài nguyên crawl) VÀ sử dụng

meta noindex(để đảm bảo không lập chỉ mục nếu Googlebot bằng cách nào đó vẫn tìm thấy). Tuy nhiên, nếu bạn chặn một trang bằng robots.txt, Googlebot sẽ không bao giờ nhìn thấy thẻnoindex. Do đó, nếu mục tiêu lànoindexthì đừng chặn nó trong robots.txt.

Bằng cách áp dụng các quy tắc Disallow một cách chiến lược, bạn có thể quản lý bot hiệu quả, giúp Googlebot tập trung vào các nội dung quan trọng và tăng cường hiệu quả SEO cho website đăng ký mã vạch sản phẩm của bạn.

Các phương pháp nào giúp tối ưu hóa robots.txt để tăng cường crawlability?

Việc tối ưu hóa robots.txt không chỉ dừng lại ở việc sửa robots.txt để Google crawl các trang quan trọng và chặn các trang không mong muốn. Nó còn liên quan đến việc cải thiện hiệu quả tổng thể của quá trình thu thập thông tin (crawlability) của Googlebot, giúp trang web của bạn được lập chỉ mục nhanh hơn và chính xác hơn. Điều này đặc biệt quan trọng cho các website đăng ký mã vạch sản phẩm nơi thông tin sản phẩm mới cần được cập nhật thường xuyên.

1. Luôn khai báo Sitemap XML

Đây là một trong những cách hiệu quả nhất để thông báo cho Googlebot về tất cả các trang quan trọng trên website của bạn. Mặc dù robots.txt hướng dẫn bot không đi đâu, sitemap lại hướng dẫn bot ĐI ĐÂU.

- Cách thực hiện: Thêm dòng sau vào cuối tệp robots.txt của bạn:

Sitemap: https://thietkewebwio.com/sitemap_index.xml

(Thay đổi URLsitemap_index.xmlthành đường dẫn chính xác của tệp sitemap của bạn.) - Lợi ích: Giúp Googlebot dễ dàng khám phá tất cả các URL trên trang web của bạn, đặc biệt là các trang mới hoặc các trang có ít liên kết nội bộ. Điều này cực kỳ hữu ích cho các trang sản phẩm và đăng ký mã vạch mới.

2. Sử dụng quy tắc Allow cụ thể để ghi đè Disallow

Trong một số trường hợp, bạn có thể có một quy tắc Disallow rộng hơn, nhưng muốn cho phép một thư mục con hoặc tệp cụ thể bên trong thư mục đó. Quy tắc Allow có độ ưu tiên cao hơn.

- Ví dụ: Bạn muốn chặn tất cả các tệp PHP, nhưng lại muốn Google crawl một tệp PHP cụ thể là trang đăng ký mã vạch.

User-agent: *

Disallow: /*.php$

Allow: /dang-ky-ma-vach/index.php

Quy tắc này sẽ giúp bạn sửa robots.txt để Google crawl tệpindex.phpcụ thể đó mà không ảnh hưởng đến các tệp PHP khác.

3. Tránh sử dụng Disallow cho các tệp CSS/JS quan trọng

Googlebot ngày càng thông minh hơn và cần truy cập các tệp CSS và JavaScript để rendering (kết xuất) trang web của bạn. Việc chặn các tài nguyên này có thể khiến Googlebot không thể hiểu đúng bố cục và nội dung của trang, ảnh hưởng tiêu cực đến thứ hạng.

- Hạn chế: Trừ khi bạn có lý do rất cụ thể, không nên có

Disallow: /*.css$hoặcDisallow: /*.js$trong tệp robots.txt của bạn.

4. Giữ robots.txt đơn giản và rõ ràng

Một tệp robots.txt quá phức tạp với nhiều quy tắc chồng chéo có thể dẫn đến lỗi và khó quản lý. Mục tiêu khi sửa robots.txt để Google crawl là sự hiệu quả, không phải sự phức tạp.

- Nguyên tắc: Chỉ chặn những gì thực sự cần chặn. Tránh các quy tắc quá chung chung nếu bạn không chắc chắn về tác động của chúng.

- Mẹo: Khi bạn tạo tệp robots.txt, hãy kiểm tra nó thường xuyên bằng Google Search Console để đảm bảo không có vấn đề gì.

5. Sử dụng công cụ kiểm tra robots.txt của Google Search Console

Sau mỗi lần chỉnh sửa robots.txt, hãy sử dụng công cụ này để kiểm tra ngay lập tức.

- Cách sử dụng: Vào Google Search Console > Cài đặt > Công cụ kiểm tra robots.txt. Nhập các URL quan trọng (trang sản phẩm, đăng ký mã vạch) và các URL bạn muốn chặn để xác nhận chúng hoạt động đúng như mong đợi.

- Lợi ích: Giúp bạn phát hiện và khắc phục lỗi ngay lập tức, đảm bảo rằng việc sửa robots.txt để Google crawl không tạo ra vấn đề mới.

6. Cân nhắc tốc độ crawl (Crawl rate)

Mặc dù robots.txt không trực tiếp kiểm soát tốc độ crawl, nhưng việc chặn các trang không quan trọng sẽ giúp Googlebot không lãng phí tài nguyên, từ đó tập trung vào các trang quan trọng hơn.

- Đề xuất: Nếu bạn có một trang web rất lớn với hàng trăm nghìn trang và muốn Google crawl các trang mới nhanh hơn, việc giảm tải cho Googlebot bằng cách chặn các phần không cần thiết là một chiến lược hiệu quả.

- Lưu ý: Googlebot có cơ chế tự điều chỉnh tốc độ crawl. Bạn chỉ nên thay đổi tốc độ crawl thông qua Google Search Console nếu bạn gặp vấn đề lớn về hiệu suất máy chủ.

Bằng cách áp dụng các phương pháp tối ưu hóa này, bạn không chỉ biết cách sửa robots.txt để Google crawl hiệu quả mà còn giúp tăng cường khả năng hiển thị website của mình trên các công cụ tìm kiếm, đặc biệt là trong lĩnh vực đăng ký mã vạch sản phẩm cạnh tranh. Một robots.txt được cấu hình tốt là nền tảng vững chắc cho một chiến lược SEO thành công.

Câu hỏi thường gặp về cách sửa robots.txt để Google crawl hiệu quả (FAQPage & HowTo)

Dưới đây là các câu hỏi thường gặp về cách sửa robots.txt để Google crawl các website đăng ký mã vạch sản phẩm một cách hiệu quả, giúp bạn dễ dàng tìm thấy câu trả lời và áp dụng ngay lập tức.

1. robots.txt là gì và tại sao nó quan trọng để Google crawl?

robots.txt là một tệp văn bản đơn giản nằm ở thư mục gốc của website, hướng dẫn các trình thu thập thông tin (spider, bot) của công cụ tìm kiếm (như Googlebot) rằng chúng có thể hoặc không thể truy cập phần nào trên trang web của bạn. Nó quan trọng để Google crawl vì:

- Kiểm soát quyền truy cập: Nó giúp bạn ngăn chặn Googlebot truy cập các khu vực nhạy cảm, riêng tư hoặc không cần thiết (ví dụ: trang quản trị, trang giỏ hàng).

- Tối ưu hóa ngân sách crawl (crawl budget): Bằng cách chặn các trang không quan trọng, bạn giúp Googlebot tập trung tài nguyên vào các trang có giá trị, đảm bảo các trang sản phẩm và đăng ký mã vạch của bạn được crawl và lập chỉ mục nhanh hơn.

- Tránh nội dung trùng lặp: Có thể được sử dụng để ngăn chặn Googlebot truy cập các URL có tham số gây trùng lặp, mặc dù meta noindex thường hiệu quả hơn cho mục đích này.

2. Nếu tôi không có tệp robots.txt, điều gì sẽ xảy ra với Google crawl?

Nếu bạn không có tệp robots.txt, Googlebot sẽ giả định rằng nó được phép truy cập và crawl TẤT CẢ các trang trên website của bạn. Điều này không nhất thiết là xấu, nhưng có thể dẫn đến việc Googlebot tốn tài nguyên crawl vào các trang không quan trọng hoặc gây trùng lặp nội dung. Để kiểm soát chặt chẽ hơn và tối ưu hóa quá trình thu thập dữ liệu, bạn nên tạo tệp robots.txt để sửa robots.txt để Google crawl theo ý muốn.

3. Tôi nên đưa những URL nào vào robots.txt để Disallow (chặn)?

Bạn nên Disallow những URL hoặc thư mục sau đây để chặn Google crawl và tối ưu hóa ngân sách crawl:

- Các trang quản trị:

/wp-admin/,/backend/,/admin/ - Các tệp cấu hình/hệ thống:

/wp-includes/,/cgi-bin/ - Các trang đăng nhập/đăng ký người dùng:

/login/,/register/,/my-account/(trừ khi là trang đăng ký dịch vụ chính mà bạn muốn hiển thị) - Các trang giỏ hàng và thanh toán:

/cart/,/checkout/ - Các trang kết quả tìm kiếm nội bộ:

/search?q=,/tim-kiem/ - Các trang có tham số URL vô nghĩa hoặc gây trùng lặp:

/*?sort=*,/*?filter=*,/*?color=*(sử dụng cẩn thận) - Các tệp tài nguyên không cần thiết hoặc nhạy cảm:

*.zip$,*.rar$, các thư mục chứa tài liệu nội bộ.

4. Tôi có thể sử dụng robots.txt để xóa một trang khỏi kết quả tìm kiếm Google không?

Không hoàn toàn. robots.txt chỉ ngăn chặn Googlebot truy cập và crawl một trang. Nếu trang đó đã được lập chỉ mục hoặc có các backlink mạnh mẽ trỏ về, nó vẫn CÓ THỂ xuất hiện trong kết quả tìm kiếm. Để đảm bảo một trang hoàn toàn không xuất hiện, bạn phải sử dụng thẻ meta robots noindex trong HTML của trang đó: <meta name="robots" content="noindex, follow">. Lưu ý rằng để Googlebot thấy được thẻ noindex, bạn KHÔNG ĐƯỢC chặn trang đó trong robots.txt.

5. Làm thế nào để kiểm tra xem robots.txt của tôi có đang hoạt động đúng cách không?

How-To

- Truy cập Google Search Console: Đảm bảo trang web của bạn đã được xác minh trong Google Search Console.

- Mở công cụ kiểm tra robots.txt: Điều hướng đến “Công cụ kiểm tra robots.txt” (thường nằm trong mục “Cài đặt” hoặc “Chỉ mục” tùy phiên bản GSC).

- Nhập URL và kiểm tra:

- Nhập một URL mà bạn muốn Googlebot crawl (ví dụ:

https://thietkewebwio.com/san-pham/mau-ma-vach-a) và xem kết quả là “Allowed”. - Nhập một URL mà bạn muốn chặn (ví dụ:

https://thietkewebwio.com/wp-admin/) và xem kết quả là “Blocked”.

- Nhập một URL mà bạn muốn Googlebot crawl (ví dụ:

- Kiểm tra lỗi tiềm ẩn: Công cụ này cũng sẽ hiển thị bất kỳ lỗi cú pháp nào trong tệp robots.txt của bạn.

Việc kiểm tra này là cực kỳ quan trọng sau mỗi lần bạn sửa robots.txt để Google crawl theo cách mới.

6. Tôi có thể sử dụng các ký tự đại diện (wildcards) trong robots.txt không?

Có, bạn có thể sử dụng các ký tự đại diện:

*(dấu sao): Đại diện cho bất kỳ chuỗi ký tự nào.- Ví dụ:

Disallow: /wp-*/sẽ chặn tất cả các thư mục bắt đầu bằngwp-(ví dụ:/wp-admin/,/wp-includes/). - Ví dụ:

Disallow: /*?sẽ chặn tất cả các URL có tham số truy vấn.

- Ví dụ:

$(dấu đô la): Đại diện cho cuối một URL.- Ví dụ:

Disallow: /*.pdf$sẽ chặn tất cả các tệp có đuôi.pdf.

- Ví dụ:

Việc sử dụng ký tự đại diện giúp viết các quy tắc ngắn gọn và mạnh mẽ hơn khi sửa robots.txt để Google crawl.

7. Việc thay đổi robots.txt mất bao lâu để Google cập nhật?

Googlebot thường truy cập và kiểm tra tệp robots.txt của bạn định kỳ (thường là hàng ngày hoặc vài ngày một lần, tùy thuộc vào tần suất cập nhật trang web của bạn và uy tín của nó). Thông thường, các thay đổi trong robots.txt sẽ được Googlebot ghi nhận trong vòng vài giờ đến vài ngày. Nếu bạn muốn đẩy nhanh quá trình, bạn có thể gửi lại tệp robots.txt thông qua Google Search Console, hoặc đơn giản hơn, yêu cầu lập chỉ mục cho một trang bất kỳ.

Lời kết

Việc hiểu rõ về cách sửa robots.txt để Google crawl không chỉ là một kỹ năng SEO cơ bản mà còn là yếu tố then chốt để đảm bảo website đăng ký mã vạch sản phẩm của bạn được Google lập chỉ mục một cách hiệu quả và tối ưu. Bằng cách thực hiện đúng các hướng dẫn trong bài viết này, bạn sẽ giúp Googlebot dễ dàng khám phá các nội dung quan trọng, nâng cao khả năng hiển thị trên công cụ tìm kiếm và thu hút được nhiều khách hàng tiềm năng hơn.

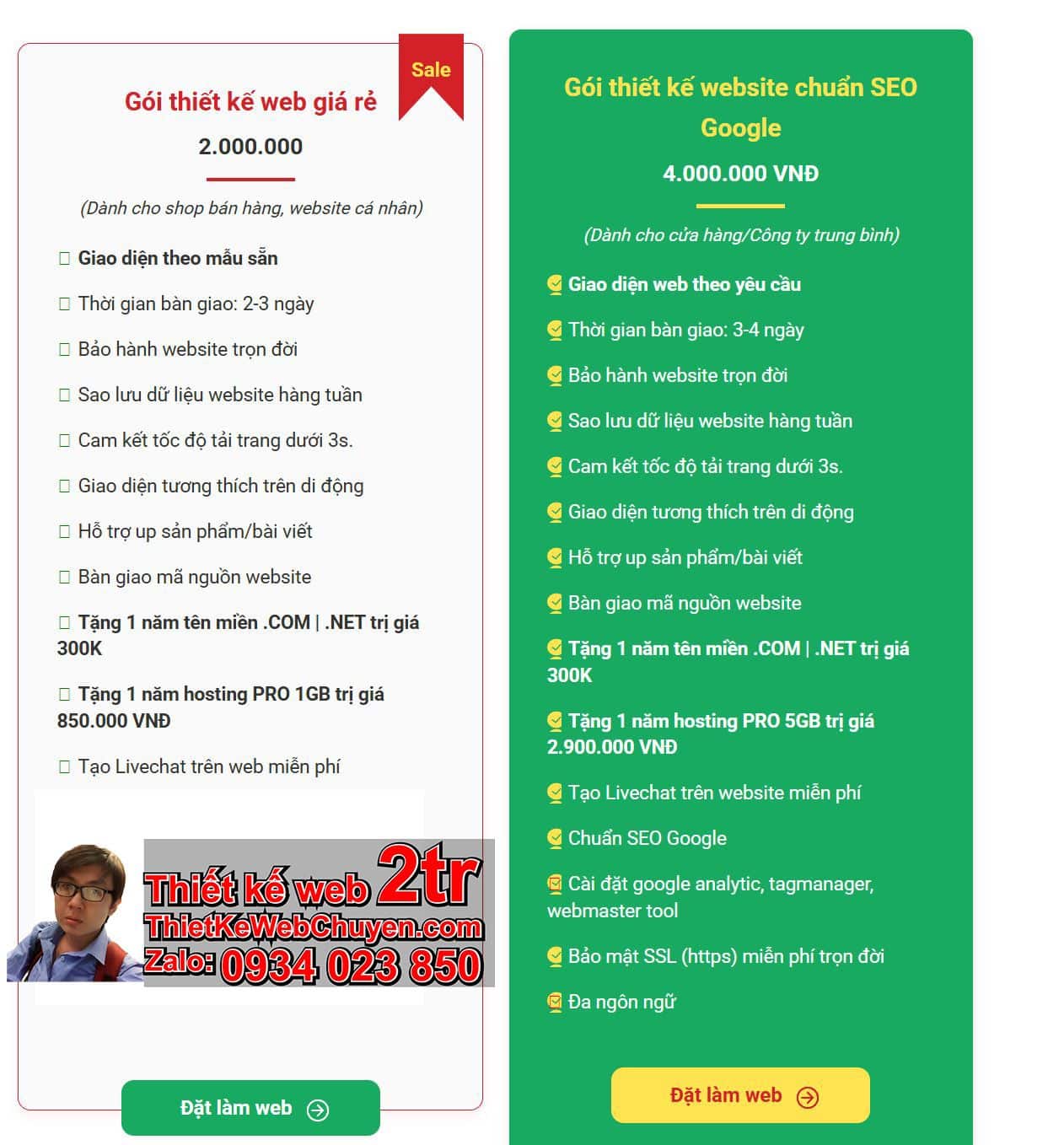

Đừng ngần ngại liên hệ ThietKeWebWio.com qua Zalo 0934 023 850 nếu bạn cần hỗ trợ về SEO website, thiết kế web hoặc tối ưu hóa robots.txt cho doanh nghiệp của mình. Chúng tôi luôn sẵn lòng tư vấn và cung cấp các giải pháp chuyên nghiệp, giúp website của bạn phát triển bền vững trên môi trường trực tuyến.

Tìm hiểu thêm về cách đưa website lên Google:

- Cách đưa web lên Google: https://thietkewebwio.com/cach-dua-web-len-google/

- Cách đưa web lên Google: https://thietkewebchuyen.com/cach-dua-web-len-google.html