Để xử lý “Blocked by robots.txt” hiệu quả, bạn cần kiểm tra và chỉnh sửa file robots.txt, đảm bảo không chặn nhầm các trang quan trọng. Sau đó, yêu cầu Google bot thu thập lại dữ liệu hoặc sử dụng công cụ kiểm tra robots.txt của Google Search Console để xác định và khắc phục lỗi. Việc này đặc biệt quan trọng trong đăng ký mã vạch sản phẩm và các ngành cần SEO chi tiết.

Cách xử lý “Blocked by robots.txt” hiệu quả cho website

Bạn đang gặp phải thông báo “Blocked by robots.txt” trong Google Search Console và không biết cách xử lý “Blocked by robots.txt” như thế nào? Đây là một vấn đề phổ biến có thể ảnh hưởng nghiêm trọng đến khả năng hiển thị của trang web trên Google, đặc biệt quan trọng đối với các doanh nghiệp hoạt động trong lĩnh vực đăng ký mã vạch sản phẩm hoặc bất kỳ ai muốn nội dung của mình được lập chỉ mục. Trong bài viết này, chúng tôi sẽ hướng dẫn bạn cách xử lý “Blocked by robots.txt” một cách chi tiết và chuyên sâu, đảm bảo trang web của bạn được Google bot thu thập dữ liệu và xếp hạng tối ưu.

Blocked by robots.txt là gì và tại sao nó lại quan trọng?

Trước khi đi sâu vào cách xử lý “Blocked by robots.txt”, chúng ta cần hiểu rõ khái niệm này. File robots.txt là một tệp văn bản bạn đặt trên máy chủ gốc của trang web (ví dụ: yourdomain.com/robots.txt). Mục đích của nó là hướng dẫn các trình thu thập dữ liệu web (như Googlebot) truy cập vào những phần nào của trang web và không truy cập vào những phần nào. Khi Google Search Console báo cáo “Blocked by robots.txt”, điều đó có nghĩa là file robots.txt của bạn đang ngăn Google bot thu thập dữ liệu và lập chỉ mục một hoặc nhiều trang trên website.

Điều này cực kỳ quan trọng vì nếu một trang bị chặn bởi robots.txt, nó sẽ không xuất hiện trong kết quả tìm kiếm của Google. Đối với các trang đăng ký mã vạch sản phẩm, trang sản phẩm, bài viết blog quan trọng hay bất kỳ nội dung nào bạn muốn người dùng tìm thấy, việc bị chặn bởi robots.txt đồng nghĩa với việc mất đi lưu lượng truy cập tiềm năng và doanh thu. Vì vậy, việc biết cách xử lý “Blocked by robots.txt” là kiến thức nền tảng trong SEO.

Cách kiểm tra xem trang của bạn có bị chặn bởi robots.txt hay không?

Bạn muốn biết cách xử lý “Blocked by robots.txt” nhưng không chắc trang của mình có thực sự bị chặn không? Có vài cách kiểm tra robots.txt để xác định vấn đề này.

1. Sử dụng Google Search Console để phát hiện chặn bởi robots.txt

Đây là công cụ hữu ích nhất để phát hiện lỗi này.

- Bước 1: Đăng nhập Google Search Console. Chọn tài sản trang web của bạn.

- Bước 2: Chuyển đến mục “Lập chỉ mục” (Indexing) > “Trang” (Pages). Tại đây, bạn sẽ thấy tổng quan về tình trạng lập chỉ mục của trang web.

- Bước 3: Tìm mục “Tại sao trang không được lập chỉ mục” (Why pages aren’t indexed). Trong danh sách này, nếu có lỗi “Bị chặn bởi robots.txt” (Blocked by robots.txt), hãy nhấp vào để xem danh sách các URL bị ảnh hưởng. Đây chính là những trang bạn cần thực hiện cách xử lý “Blocked by robots.txt”.

2. Kiểm tra thủ công file robots.txt của bạn

Mở trình duyệt web và truy cập vào đường dẫn yourdomain.com/robots.txt. Xem xét nội dung của file này. Tìm kiếm các lệnh Disallow có thể chặn các đường dẫn quan trọng. Ví dụ:

User-agent: *(Áp dụng cho tất cả các trình thu thập dữ liệu)Disallow: /(Chặn toàn bộ website)Disallow: /wp-admin/(Chặn thư mục wp-admin, thường không sao)Disallow: /san-pham/(Đây có thể là vấn đề lớn nếu thư mục này chứa các trang đăng ký mã vạch sản phẩm quan trọng)

Nếu bạn thấy Disallow: / hoặc Disallow các thư mục chứa nội dung quan trọng, đó chính là nguyên nhân bạn cần xử lý “Blocked by robots.txt”.

3. Sử dụng công cụ kiểm tra robots.txt của Google

Trong Google Search Console, bạn có thể tìm thấy công cụ “Trình kiểm tra robots.txt” (Robots.txt Tester) trong mục “Cài đặt cũ (Legacy tools and reports)” hoặc tìm kiếm trực tiếp. Công cụ này cho phép bạn:

- Xem phiên bản robots.txt hiện tại mà Google đang đọc.

- Chèn một URL cụ thể và kiểm tra xem Googlebot có bị chặn khi cố gắng truy cập URL đó hay không.

- Sửa đổi file robots.txt trong giao diện công cụ để thử nghiệm các thay đổi trước khi áp dụng trực tiếp lên máy chủ.

Công cụ này giúp bạn xác định chính xác vấn đề và là bước đầu tiên trong cách xử lý “Blocked by robots.txt”.

Cách xử lý “Blocked by robots.txt” chi tiết và từng bước

Khi đã xác định được nguyên nhân, hãy cùng tìm hiểu cách xử lý “Blocked by robots.txt” từng bước một.

Bước 1: Xác định các trang bị ảnh hưởng và đánh giá mức độ quan trọng

Trước tiên, hãy lập danh sách tất cả các URL mà Google Search Console báo cáo là “Blocked by robots.txt”. Sau đó, đánh giá mức độ quan trọng của từng URL:

- Có phải là trang người dùng cần tìm thấy không? (Ví dụ: trang chủ, trang sản phẩm, trang dịch vụ đăng ký mã vạch sản phẩm, bài viết blog quan trọng).

- Có phải là trang quản trị, trang thử nghiệm, hoặc trang trùng lặp không? (Ví dụ:

/wp-admin/,/temp/, các trang giỏ hàng không cần lập chỉ mục).

Nếu các trang quan trọng bị chặn, bạn cần ưu tiên xử lý “Blocked by robots.txt” cho chúng.

Bước 2: Chỉnh sửa file robots.txt để cho phép Google bot truy cập

Đây là bước quan trọng nhất trong cách xử lý “Blocked by robots.txt”.

Truy cập vào file robots.txt:

- Nếu bạn sử dụng WordPress: Có thể chỉnh sửa file này thông qua plugin SEO như Yoast SEO hoặc Rank Math (thường nằm trong mục “Tools” hoặc “General Settings” của plugin). Hoặc kết nối qua FTP/SFTP đến máy chủ và tìm file

robots.txtở thư mục gốc của trang web. - Nếu bạn không dùng WordPress hoặc có hệ thống CMS khác: Cần truy cập vào máy chủ hosting của mình qua FTP/SFTP hoặc trình quản lý tệp (File Manager) và tìm file

robots.txttrong thư mục gốc (thường làpublic_html,www, hoặchtdocs).

- Nếu bạn sử dụng WordPress: Có thể chỉnh sửa file này thông qua plugin SEO như Yoast SEO hoặc Rank Math (thường nằm trong mục “Tools” hoặc “General Settings” của plugin). Hoặc kết nối qua FTP/SFTP đến máy chủ và tìm file

Chỉnh sửa nội dung file robots.txt:

- Kiểm tra dòng

Disallow: /: Nếu bạn thấy dòng này, có nghĩa là toàn bộ trang web của bạn đang bị chặn. Hãy xóa nó nếu bạn muốn Google index toàn bộ trang. - Tìm các dòng

Disallowcụ thể: Ví dụ:Disallow: /san-pham/Disallow: /dich-vu-dang-ky-ma-vach/

Nếu các đường dẫn này chứa nội dung quan trọng, hãy xóa dòngDisallowđó hoặc thay đổi thànhAllow(mặc dùAllowkhông bắt buộc, chỉ cần không cóDisallowlà đủ).

- Ví dụ về file robots.txt cho phép đầy đủ (ngoại trừ admin):

User-agent: *

Allow: /

Disallow: /wp-admin/

Disallow: /wp-includes/ # Thường chặn các thư mục này để bảo mật

Sitemap: https://yourdomain.com/sitemap_index.xml # Đảm bảo có đường dẫn đến Sitemap của bạn

File robots.txt của bạn phải trông tương tự hoặc chỉ có lệnhDisallowcho các thư mục không cần thiết.

- Kiểm tra dòng

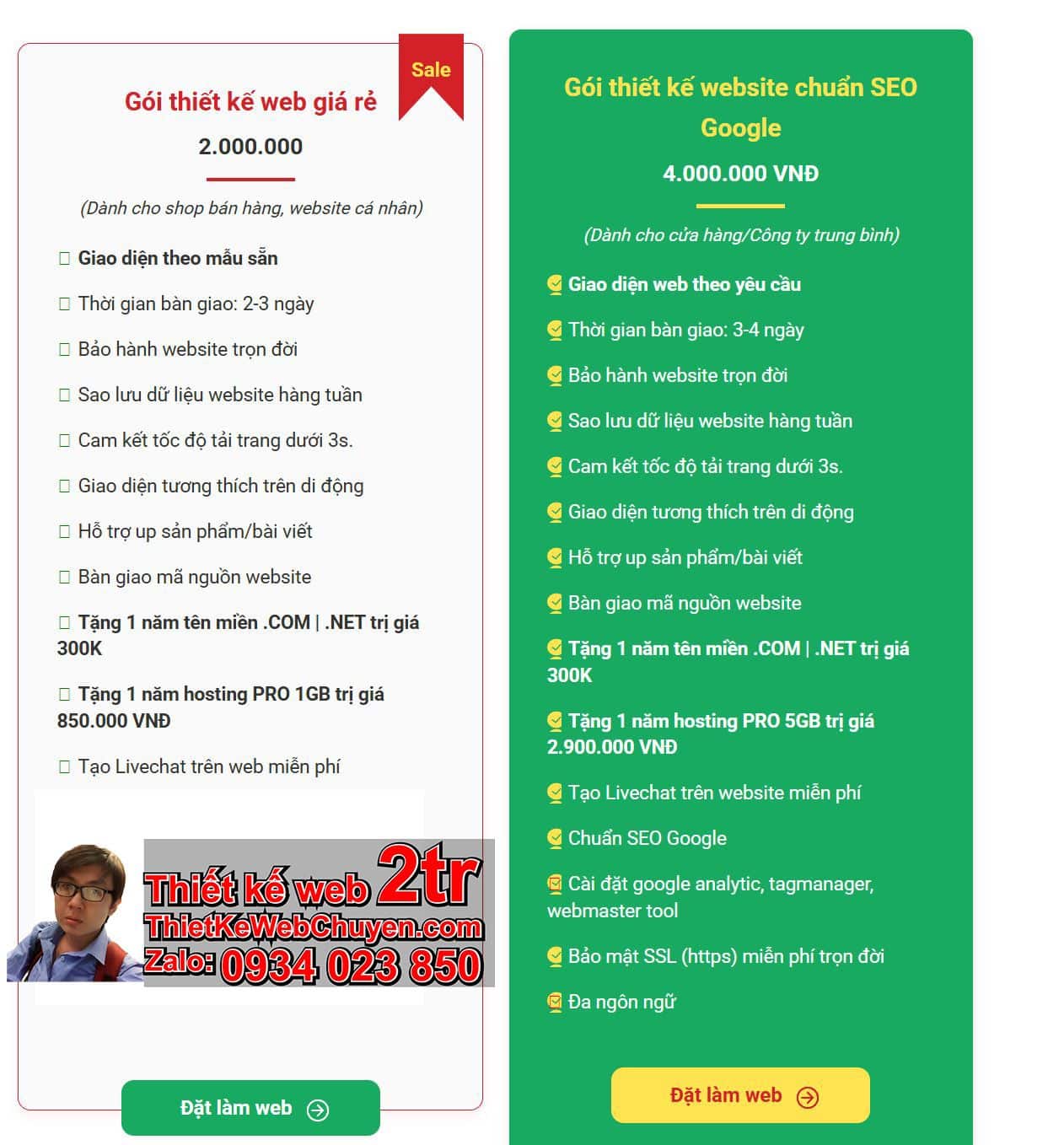

Đây là ví dụ hình ảnh về một trang web:

Bước 3: Sử dụng công cụ kiểm tra robots.txt của Google Search Console

Sau khi chỉnh sửa và lưu file robots.txt, hãy quay lại công cụ “Trình kiểm tra robots.txt” trong Google Search Console.

- Tải lên file robots.txt đã chỉnh sửa (hoặc công cụ sẽ tự động đọc phiên bản mới nhất).

- Nhập lại các URL đã bị chặn vào công cụ kiểm tra để xác nhận rằng chúng không còn bị chặn nữa. Nếu công cụ báo “Allowed”, bạn đã thành công trong việc xử lý “Blocked by robots.txt”.

Bước 4: Yêu cầu Google thu thập lại dữ liệu (Submit URL for Indexing)

Sau khi đã chỉnh sửa robots.txt và xác nhận rằng các trang không còn bị chặn, bạn cần thông báo cho Google biết để thu thập lại dữ liệu.

- Trong Google Search Console, vào mục “URL kiểm tra” (URL Inspection).

- Nhập từng URL bị ảnh hưởng vào thanh tìm kiếm ở trên cùng.

- Sau khi Google kiểm tra trạng thái của URL, bạn sẽ thấy thông báo “Trang đã được lập chỉ mục” hoặc “URL này chưa có trên Google”.

- Nhấp vào nút “Yêu cầu lập chỉ mục” (Request Indexing). Điều này sẽ đưa URL vào hàng đợi để Googlebot thu thập dữ liệu lại.

Quá trình xử lý “Blocked by robots.txt” cần sự kiên nhẫn. Googlebot có thể mất vài ngày đến vài tuần để đọc lại robots.txt và thu thập dữ liệu các trang của bạn.

Các nguyên nhân phổ biến khác và cách phòng tránh lỗi “Blocked by robots.txt”

Ngoài việc xử lý “Blocked by robots.txt” khi đã xảy ra, việc hiểu các nguyên nhân robots.txt phổ biến giúp bạn phòng tránh.

1. Cài đặt plugin SEO không đúng cách

Một số plugin SEO có tùy chọn để “ngăn các công cụ tìm kiếm lập chỉ mục trang web này”. Nếu bạn vô tình bật tùy chọn này, plugin có thể tự động thêm Disallow: / vào file robots.txt của bạn. Luôn kiểm tra cài đặt của plugin SEO sau khi cài đặt hoặc cập nhật.

2. Website đang ở chế độ bảo trì hoặc phát triển

Khi bạn đang phát triển hoặc bảo trì website, bạn có thể chặn toàn bộ trang bằng robots.txt để tránh Google lập chỉ mục nội dung chưa hoàn thiện. Tuy nhiên, nếu quên bỏ chặn khi website đã hoàn thành, lỗi “Blocked by robots.txt” sẽ xuất hiện. Luôn kiểm tra file này trước khi ra mắt website chính thức.

3. Lỗi chính tả hoặc cú pháp trong file robots.txt

Một lỗi nhỏ trong cú pháp cũng có thể khiến toàn bộ hoặc một phần lớn trang web bị chặn. Ví dụ: sai chính tả, thiếu dấu gạch chéo /, hoặc sai lệnh. Luôn sử dụng công cụ kiểm tra robots.txt của Google để xác minh cú pháp sau khi chỉnh sửa.

4. Chặn nhầm các tài nguyên quan trọng (CSS, JS) bởi robots.txt

Mặc dù bạn nên chặn các thư mục quản trị, nhưng việc chặn các tệp CSS, JavaScript hoặc hình ảnh quan trọng có thể khiến Googlebot không thể hiển thị trang web của bạn một cách chính xác (Mobile-Friendly Test sẽ báo lỗi). Google cần truy cập các tài nguyên này để hiểu cách trang của bạn hiển thị và trải nghiệm người dùng. Vì vậy, trong cách xử lý “Blocked by robots.txt”, hãy chắc chắn không chặn chúng.

5. Hosting hoặc CDN chặn truy cập của Googlebot

Trong một số trường hợp hiếm hoi, cấu hình máy chủ web (hosting) hoặc Mạng phân phối nội dung (CDN) có thể vô tình chặn các IP của Googlebot. Nếu không có cách xử lý “Blocked by robots.txt” nào từ file robots.txt, hãy liên hệ nhà cung cấp hosting hoặc CDN của bạn để kiểm tra.

Ảnh hưởng của “Blocked by robots.txt” đến SEO và giải pháp khắc phục

Khi gặp lỗi Bị chặn bởi robots.txt, nó ảnh hưởng trực tiếp đến SEO trang web của bạn.

- Giảm khả năng hiển thị trên công cụ tìm kiếm: Các trang bị chặn không thể xuất hiện trong kết quả tìm kiếm, làm mất cơ hội tiếp cận khách hàng tiềm năng. Điều này đặc biệt tai hại cho các trang đăng ký mã vạch sản phẩm cần hiển thị rõ ràng.

- Ảnh hưởng đến trải nghiệm người dùng: Nếu các trang quan trọng bị chặn, người dùng sẽ không tìm thấy thông tin họ cần, dẫn đến trải nghiệm kém.

- Lãng phí nguồn lực thu thập dữ liệu: Googlebot vẫn có thể “nhìn thấy” thẻ

Disallowtrong robots.txt nhưng không thể thu thập dữ liệu bên trong. Điều này không hiệu quả và lãng phí “crawl budget”.

Giải pháp khắc phục:

- Thực hiện đúng theo các bước cách xử lý “Blocked by robots.txt” đã nêu trên.

- Ưu tiên các trang quan trọng: Khi xử lý “Blocked by robots.txt”, luôn tập trung vào các trang sản phẩm, dịch vụ, bài viết có giá trị trước.

- Theo dõi Google Search Console thường xuyên: Kiểm tra báo cáo “Trang” và “Lỗi thu thập dữ liệu” để phát hiện sớm các vấn đề.

- Có tầm nhìn dài hạn: Đối với các doanh nghiệp đăng ký mã vạch sản phẩm hoặc kinh doanh trực tuyến, SEO là một quá trình liên tục. Việc đảm bảo Googlebot có thể truy cập và lập chỉ mục mọi trang quan trọng là nền tảng của mọi chiến lược SEO thành công.

FAQpage: Các câu hỏi thường gặp về cách xử lý “Blocked by robots.txt”

Dưới đây là một số câu hỏi liên quan đến cách xử lý “Blocked by robots.txt” mà bạn có thể gặp phải:

1. robots.txt có phải là cách duy nhất để chặn Google lập chỉ mục không?

Không. Ngoài cách xử lý “Blocked by robots.txt”, bạn cũng có thể sử dụng thẻ meta noindex trong phần <head> của trang HTML. Ví dụ: <meta name="robots" content="noindex">. Thẻ này sẽ cho phép Googlebot truy cập trang nhưng không lập chỉ mục nó. Điều này hữu ích khi bạn muốn chặn lập chỉ mục nhưng vẫn cần Googlebot “đọc” nội dung trang để hiểu các đường dẫn liên kết bên trong.

**2. Bao lâu thì Google Search Console cập nhật sau khi tôi đã **xử lý “Blocked by robots.txt”?

Thời gian cập nhật có thể khác nhau. Sau khi bạn chỉnh sửa robots.txt và yêu cầu lập chỉ mục, Googlebot cần thời gian để đọc file robots.txt mới, sau đó thu thập dữ liệu lại các trang. Quá trình này có thể mất từ vài ngày đến vài tuần. Luôn kiểm tra lại báo cáo trong Google Search Console sau một thời gian.

3. Tôi có thể chặn lập chỉ mục một trang cụ thể mà không ảnh hưởng đến các trang khác không?

Có. Để chặn một trang cụ thể, bạn có thể thêm dòng Disallow chính xác cho URL đó trong file robots.txt. Ví dụ: Disallow: /ten-trang-can-chan.html. Tuy nhiên, cách tốt hơn để chặn một trang cụ thể là sử dụng thẻ meta noindex trên chính trang đó, vì nó linh hoạt hơn và không yêu cầu Googlebot phải đọc robots.txt để biết cần làm gì. Cả hai đều là một phần của cách xử lý “Blocked by robots.txt” liên quan đến việc hạn chế lập chỉ mục.

**4. Chặn thư mục wp-admin có phải là *cách xử lý “Blocked by robots.txt”* cần thiết không?**

Có, việc chặn thư mục wp-admin (đối với WordPress) và các thư mục quản trị tương tự là một thực hành tốt. Các trang trong thư mục này thường không hữu ích cho người dùng cuối và việc chặn chúng giúp tiết kiệm ngân sách thu thập dữ liệu của Googlebot, tập trung vào nội dung quan trọng hơn. Đây là một phần hợp lý trong quản lý robots.txt.

5. Liệu việc sửa chữa file robots.txt có làm mất thứ hạng hiện tại của trang không?

Không. Ngược lại, việc xử lý “Blocked by robots.txt” giúp các trang của bạn có cơ hội được lập chỉ mục và xếp hạng cao hơn. Nếu trang đã bị chặn, nó gần như không có thứ hạng. Việc sửa lỗi robots.txt sẽ mở đường cho Googlebot truy cập và đánh giá lại nội dung của bạn một cách tích cực hơn.

**HowTo: Các bước thực hiện để *xử lý “Blocked by robots.txt”***

Học cách xử lý “Blocked by robots.txt” từng bước là vô cùng quan trọng. Dưới đây là tóm tắt các bước thực hiện:

1. Xác định lỗi “Blocked by robots.txt”

- Sử dụng Google Search Console: Kiểm tra báo cáo “Trang” (Pages) dưới mục “Lập chỉ mục” (Indexing) để tìm các URL bị chặn.

- Kiểm tra thủ công robots.txt: Truy cập

yourdomain.com/robots.txtđể xem các lệnhDisallow. - Dùng công cụ kiểm tra robots.txt: Nhập URL cụ thể vào công cụ để xác định chính xác trạng thái chặn.

2. Chỉnh sửa file robots.txt

- Truy cập file: Dùng plugin SEO (WordPress) hoặc FTP/File Manager (hosting) để vào file

robots.txtở thư mục gốc. - Xóa hoặc sửa lệnh

Disallow: Gỡ bỏDisallow: /nếu bạn muốn index toàn bộ trang. Xóa các dòngDisallowchặn nhầm các thư mục hoặc trang quan trọng (như trang đăng ký mã vạch sản phẩm). - Lưu thay đổi: Đảm bảo file được lưu và upload lên máy chủ.

3. Xác nhận thay đổi bằng công cụ kiểm tra robots.txt

- Quay lại Google Search Console: Sử dụng công cụ “Trình kiểm tra robots.txt” để nhập các URL đã bị chặn trước đó.

- Kiểm tra kết quả: Đảm bảo công cụ báo “Allowed” cho các URL đó.

4. Yêu cầu Google lập chỉ mục lại

- Sử dụng “URL kiểm tra”: Nhập từng URL đã sửa vào thanh kiểm tra và nhấp “Yêu cầu lập chỉ mục”.

5. Theo dõi kết quả

- Kiểm tra Google Search Console định kỳ: Theo dõi báo cáo “Trang” để xem số lượng trang được lập chỉ mục có tăng lên không và lỗi “Blocked by robots.txt” có giảm đi không.

Bằng cách tuân thủ các bước này, bạn sẽ thành công trong việc xử lý “Blocked by robots.txt” và cải thiện đáng kể khả năng hiển thị của trang web trên Google.

**Kết luận về *cách xử lý “Blocked by robots.txt”***

Việc xử lý “Blocked by robots.txt” là một kỹ năng SEO cơ bản nhưng cực kỳ quan trọng đối với bất kỳ ai quản lý website, đặc biệt là trong các lĩnh vực cạnh tranh như đăng ký mã vạch sản phẩm và thương mại điện tử. Bằng cách hiểu rõ cách thức hoạt động của file robots.txt, thường xuyên kiểm tra Google Search Console, và áp dụng các bước khắc phục chi tiết đã nêu, bạn có thể đảm bảo rằng Googlebot có quyền truy cập vào tất cả các nội dung quan trọng trên trang web của mình.

Đừng để một lỗi nhỏ trong file robots.txt cản trở sự phát triển SEO của bạn. Hãy chủ động rà soát, chỉnh sửa, và theo dõi để trang web của bạn luôn được tối ưu và hiển thị tốt nhất trên kết quả tìm kiếm của Google.

Nếu bạn cần hỗ trợ chuyên sâu hơn về cách xử lý “Blocked by robots.txt” hoặc tối ưu SEO tổng thể, đừng ngần ngại liên hệ ThietKeWebWio.com Zalo 0934 023 850. Chúng tôi có 10 năm kinh nghiệm trong việc đưa website lên Google và sẽ giúp bạn giải quyết mọi vấn đề kỹ thuật để website của bạn vươn xa hơn.

Xem thêm về cách xử lý “Blocked by robots.txt” và SEO tại: